Resumos

As escolas participam das avaliações de larga escala e nem sempre questionam seus limites e potencialidades para a análise de sua realidade. Embora acredite na importância destas avaliações na busca da qualidade educacional, o presente trabalho questiona seu uso na ancoragem de políticas públicas, problematizando a influência dos fatores externos na composição do desempenho, a utilização do Ideb como sintetizador da qualidade das instituições e o conceito de eficácia escolar. Baseando-se em dados do Projeto Geres, um estudo longitudinal de tipo painel (2005-2008), discute aspectos da análise dos resultados das avaliações de larga escala e seus instrumentos de medida, uma vez que nem sempre estes são tradutores do trabalho desenvolvido pela escola, tampouco neutros e infalíveis.

Avaliação educacional; Ideb; Nível socioeconômico; Eficácia escolar

Schools participate in large-scale assessments without questioning its limits and possibilities for analyzing their reality. Although the importance of such assessments has been recognized for the pursuit of educational quality, this paper questions their use in the context of public policies, problematizing the influence of external factors on the composition of the performance, the utilization of Ideb as the unique measure to represent the quality of institutions and the concept of school effectiveness. Relying on data from the Geres Project, a longitudinal study of the panel type (2005-2008), this paper discusses aspects considered in the analysis of the results of large-scale assessments and their measuring instruments, since these are not always able to reliably represent the work developed by the schools, neither are they neutral or infallible.

Educational evaluation; Ideb; Socio-economical status; School effectiveness

Les écoles participent aux évaluations à grande échelle et pas toujours contestent leurs limites et potentialités pour l'analyse de sa réalité. Bien qu'elle attribue de l'importance à ces évaluations dans la poursuite de la qualité de l'enseignement, la présente étude interroge son utilisation à la politique publique, l'influence de facteurs externes dans la composition du résultat, l'utilisation de l'Ideb comme synthétiseur de la qualité des institutions et le concept d'efficacité scolaire. Basée sur des données du Projet Geres, une étude longitudinale de type tableau (2005-2008), ce texte discute des aspects considérés dans l'analyse des résultats des évaluations à grande échelle et leurs instruments de mesure, puisque ceux-ci ne traduisent pas toujours le travail développé dans et par l'école et ne sont ni neutres ni infaillibles.

Évaluation de l'éducation; Ideb; Niveau socio-économique; Efficacité scolaire

ARTIGOS

O Ideb: limites e ilusões de uma política educacional* * Este estudo foi financiado pela Fapesp e pelo Programa Observatório da Educação da Capes.

The Ideb: limits and illusions of an educational policy

L'Ideb: limites et illusions d'une politique d'éducative

Luana Costa AlmeidaI; Adilson DalbenII; Luiz Carlos de FreitasIII

IFaculdade de Educação da Universidade Estadual de Campinas (Unicamp). Campinas (SP) Brasil. Contato com os autores: <luanaca@gmail.com>

IICentro Universitário Salesiano de São Paulo. São José (SP) Brasil

IIIFaculdade de Educação da Universidade Estadual de Campinas (Unicamp). Campinas (SP) Brasil

RESUMO

As escolas participam das avaliações de larga escala e nem sempre questionam seus limites e potencialidades para a análise de sua realidade. Embora acredite na importância destas avaliações na busca da qualidade educacional, o presente trabalho questiona seu uso na ancoragem de políticas públicas, problematizando a influência dos fatores externos na composição do desempenho, a utilização do Ideb como sintetizador da qualidade das instituições e o conceito de eficácia escolar. Baseando-se em dados do Projeto Geres, um estudo longitudinal de tipo painel (2005-2008), discute aspectos da análise dos resultados das avaliações de larga escala e seus instrumentos de medida, uma vez que nem sempre estes são tradutores do trabalho desenvolvido pela escola, tampouco neutros e infalíveis.

Palavras-chave: Avaliação educacional. Ideb. Nível socioeconômico. Eficácia escolar.

ABSTRACT

Schools participate in large-scale assessments without questioning its limits and possibilities for analyzing their reality. Although the importance of such assessments has been recognized for the pursuit of educational quality, this paper questions their use in the context of public policies, problematizing the influence of external factors on the composition of the performance, the utilization of Ideb as the unique measure to represent the quality of institutions and the concept of school effectiveness. Relying on data from the Geres Project, a longitudinal study of the panel type (2005-2008), this paper discusses aspects considered in the analysis of the results of large-scale assessments and their measuring instruments, since these are not always able to reliably represent the work developed by the schools, neither are they neutral or infallible.

Key words: Educational evaluation. Ideb. Socio-economical status. School effectiveness.

RÉSUMÉ

Les écoles participent aux évaluations à grande échelle et pas toujours contestent leurs limites et potentialités pour l'analyse de sa réalité. Bien qu'elle attribue de l'importance à ces évaluations dans la poursuite de la qualité de l'enseignement, la présente étude interroge son utilisation à la politique publique, l'influence de facteurs externes dans la composition du résultat, l'utilisation de l'Ideb comme synthétiseur de la qualité des institutions et le concept d'efficacité scolaire. Basée sur des données du Projet Geres, une étude longitudinale de type tableau (2005-2008), ce texte discute des aspects considérés dans l'analyse des résultats des évaluations à grande échelle et leurs instruments de mesure, puisque ceux-ci ne traduisent pas toujours le travail développé dans et par l'école et ne sont ni neutres ni infaillibles.

Mots-clés: Évaluation de l'éducation. Ideb. Niveau socio-économique. Efficacité scolaire.

As avaliações externas e seus resultados já fazem parte da cultura escolar, ainda que de uma forma bastante controversa. Por um lado, são muitas as críticas feitas a elas, sua finalidade, abrangência e possibilidade de análise da realidade escolar (CASASSUS, 2009; HORTA NETO, 2010; MACHADO, 2012; MADAUS; RUSSEL; HIGGINS, 2009); por outro lado, os resultados dessas avaliações têm sido apropriados pelas políticas públicas e divulgados pela mídia de tal forma que se chega a acreditar que seus efeitos são inquestionáveis e que, ao interferirem no cotidiano escolar e na vida das pessoas, o fazem de forma sempre benéfica, desconsiderando-se os diferentes tipos de erro1 1 . Salientamos diferentes tipos de erro, pois, como mostraremos em nossa discussão, alguns tipos de erro, no sentido de desvio, são inerentes à estatística e existem no campo das ciências sociais, dada a impossibilidade dos modelos matemáticos e estatísticos darem conta plenamente da complexidade e da dinâmica dos fenômenos sociais. e os variados efeitos colaterais destas políticas (RAVITCH, 2010; NICHOLS; BERLINDER, 2007; NEAL; SCHANZENBACH, 2010).

O interesse por essa prática avaliativa tem se expandido para quase o mundo todo como mostra, por exemplo, a pesquisa de Kellaghan e Greaney (1996) em 50 países de diferentes continentes e o relatório Evaluación de los Centros de Enseñanza Obligatoria en Europa (EURYDICE, 2004), que aponta a difusão das avaliações externas naquela região. É um fenômeno também presente na Índia, como mostram Muralidharan e Sundararaman (2006), sem mencionar os inúmeros estudos já realizados nos Estados Unidos, talvez o polo mais promissor dessa prática avaliativa.

No Brasil, esta lógica vem ocorrendo desde a década de 1990, quando as avaliações externas passaram a ser inseridas no cotidiano escolar através do aparato normativo-jurídico, vinculando seus resultados ao financiamento da educação e, ainda, revestida de plausíveis argumentos pedagógicos (PCNs), bem descritos por Cury (2002).

Como decorrência, houve uma ampliação da utilização dos índices gerados a partir dessas avaliações para uso nas políticas públicas, com vistas à regulação dos sistemas de ensino.

Como exemplos destes indicadores temos, no âmbito federal, o Índice de Desenvolvimento da Educação Básica (Ideb), determinado com os dados coletados a partir do Sistema de Avaliação da Educação Básica (Saeb)2 2 . O Ideb é constituído por uma das partes do SAEB. A Portaria Ministerial n. 931, de 21 de março de 2005, em seu artigo 1º, institui "o Sistema de Avaliação da Educação Básica Saeb, que será composto por dois processos de avaliação: a Avaliação Nacional da Educação Básica Aneb, e a Avaliação Nacional do Rendimento Escolar Anresc [...]". O Aneb faz um levantamento amostral, de larga escala, externo aos sistemas de ensino público e particular, de periodicidade bianual, para avaliar a qualidade, a equidade e a eficiência da educação brasileira. Enquanto o Anresc, através da Prova Brasil, faz um levantamento de dados censitário para avaliar a qualidade do ensino ministrado nas escolas. e do Censo Escolar e, no âmbito estadual, o Índice de Desenvolvimento da Educação do Estado de São Paulo (Idesp).

Esses índices são geralmente calculados a partir do desempenho medido em testes e por questionários de contexto aplicados aos sujeitos envolvidos, os quais são tomados como instrumentos precisos e, como tal, entendidos como medições objetivas, portanto geradores de informações confiáveis (MADAUS; RUSSEL; HIGGINS, 2009).

No presente trabalho questiona-se a utilização dos resultados das avaliações em larga escala e dos índices por elas criados como única fonte para a análise do trabalho desenvolvido pelas escolas, considerando que os desempenhos médios obtidos não podem ser traduzidos como retrato fiel da qualidade das instituições. Pretende-se problematizar o conceito de eficácia escolar, um entre muitos outros subjacentes a essa lógica, e contribuir com o debate acerca da avaliação educacional a partir da discussão da utilização do Ideb como instrumento capaz de aferir a qualidade educacional de nossas escolas. Problematiza-se a formulação do Ideb que não contempla o nível socioeconômico (NSE) em sua composição, assim como a própria coleta de dados para sua elaboração, a qual utiliza instrumentos cuja limitação não os coloca na condição de definir destinos ou retratar de forma completa as instituições avaliadas, considerando-se que por trás de sua aparente infalibilidade há um processo passível de erros e análises incompletas.

Desconsiderar a variável NSE faz diferença na análise?

O Ideb foi operacionalizado em 2007 como um indicador de qualidade educacional a ser utilizado tanto para orientar no planejamento de políticas públicas educacionais nos diferentes entes federativos (município, estado e Federação) e no financiamento da educação, quanto para servir como informativo à população em geral.

Para que pais e responsáveis acompanhem o desempenho da escola de seus filhos, basta verificar o Ideb da instituição, que é apresentado numa escala de zero a dez. Da mesma forma, gestores acompanham o trabalho das secretarias municipais e estaduais pela melhoria da educação. O índice é medido a cada dois anos e o objetivo é que o país, a partir do alcance das metas municipais e estaduais, tenha nota 6 em 2022 correspondente à qualidade do ensino em países desenvolvidos. (MINISTÉRIO DA EDUCAÇÃO, s./d.)

Segundo seus próprios formuladores, esse índice "combina informações de desempenho em exames padronizados (Prova Brasil ou Saeb) obtido pelos estudantes ao final das etapas de ensino (4ª e 8ª séries do ensino fundamental e 3ª série do ensino médio) com informações sobre rendimento escolar (aprovação)" (INEP-MEC, 2007, p. 1).

O fator "desempenho" está associado ao aproveitamento cognitivo dos alunos, em especial em Língua Portuguesa e Matemática, e o fator "rendimento" ao fluxo escolar, determinado a partir da taxa de aprovação medida através da razão entre o tempo necessário para conclusão da etapa de escolarização e o tempo de duração efetivamente despendido para concluí-la.

A pretensão do Ideb de sumarizar a qualidade de ensino oferecida a partir desses dois fatores não parece viável, já que incapaz de refletir a realidade das instituições, não apenas pelo que o índice deixa de considerar, em especial o NSE da população atendida, mas também pela forma como mede esses aspectos. Como bem descreve Soares (2011):

[...] o Ideb tem alta correlação com o nível socioeconômico do alunado. Assim, ao atribuir a esse indicador o status de síntese da qualidade da educação, assume-se que a escola pode superar toda a exclusão promovida pela sociedade. Há uma farta literatura que mostra que isso é impossível. Todos os alunos têm direito de aprender, e os conhecimentos e habilidades especificados para educação básica devem ser os mesmos para todos. No entanto, obter este aprendizado em escolas que atendem alunos que trazem menos de suas famílias é muito mais difícil, fato que deve ser considerado quando se usa o indicador de aprendizagem para comparar escolas e identificar sucessos.

Colaboram com essa visão trabalhos como os de César e Soares (2001), Ferrão e Fernandes (2001), Freitas (2004, 2007), Soares (2004) e Soares e Andrade (2006), que também problematizam esta questão ao evidenciarem que não podemos tomar a escola de forma isolada do seu contexto social.

Segundo Brooke e Soares (2008), seriam poucos os estudiosos que não entenderiam que a tradição de pesquisa sobre o efeito-escola e toda a polêmica da escola eficaz estão associadas (em sua origem) ao extenso survey conduzido por Coleman e seus colaboradores em meados da década de 1960.

A discussão acerca da eficácia escolar ganhou força com a publicação do Relatório Coleman (1966), que, embora em sua conclusão final não tenha indicado que as escolas americanas não faziam diferença na formação de seus alunos, reforçou a ideia de que elas se consolidavam como reprodutoras de desigualdades sociais existentes, evidenciando que o NSE dos alunos influenciava mais o desempenho escolar destes que a estrutura das escolas, sua organização e a qualificação de seus professores.3 3 . Resultados semelhantes a esse são descritos no Relatório Plowden (PLOWDEN COMMITTEE, 1967), produzido na mesma época na Inglaterra.

Observando a influência das diferenças sociais dos alunos no desempenho escolar e consequentemente no trabalho desenvolvido pela escola e sua eficácia, encontra-se nas análises de Bourdieu (1998) outro fator importante: a questão cultural. Ele evidencia que, embora o aspecto econômico seja importante para a análise da questão, há também a dimensão cultural que, como um bem capaz de favorecer o desenvolvimento dos estudantes na escola, transforma-se em um tipo de capital que pode ser mobilizado para influenciar o sucesso escolar: aspecto que chamou de "capital cultural".

Por este viés, entende-se que as diferenças socioeconômicas e culturais devem compor uma análise explicativa da diferença de desempenho dos alunos, já que não considerá-las significaria, muitas vezes, atribuir o título de boa escola a instituições que, como única e verdadeira diferenciação em relação a outras, possui alunos de maior capital socioeconômico e cultural.

Dessa análise pode-se concluir que a elaboração dos índices deveria considerar o contexto em que a escola realiza seu trabalho, já que o NSE dos alunos é a variável que mais se correlaciona com suas notas, tendo a maior parte de sua variabilidade explicada pelos fatores externos à escola (FREITAS, 2011), como também aponta Di Carlo (2010):

[...] no panorama geral, cerca de 60 por cento dos resultados do desempenho é explicado pelo aluno e as características da família (a maioria é imperceptível, mas provavelmente se refere ao rendimento/pobreza). Fatores de escolaridade observáveis e não observáveis explicam cerca de 20 por cento, a maior parte deste (10-15 por cento) se deve a efeitos de professores. O resto da variação (cerca de 20 por cento) é inexplicável (erro). Em outras palavras, embora as estimativas precisas variem, a preponderância da evidência mostra que as diferenças de realização entre os alunos são predominantemente atribuíveis a fatores externos das escolas e salas de aula [...].

Tomando a realidade brasileira, Dalben (2012) também apresenta resultados, a partir de uma pesquisa com dados longitudinais4 4 . Basicamente, as avaliações externas coletam dados de duas formas: na primeira, recorrente no Brasil e denominada avaliação com dados seccionais ou transversais, são fixados os anos de escolarização a serem avaliados e, em diferentes anos, diferentes turmas são avaliadas; na outra, longitudinal de tipo painel, há a possibilidade do cálculo do valor agregado, sendo fixados os alunos a fim de que, em diferentes anos de escolarização, eles sejam avaliados. que correlacionaram à proficiência o NSE, considerando alunos dos quatro anos iniciais do ensino fundamental, resultados estes que permitem ampliar a discussão acerca das possibilidades de se analisar o trabalho da escola, em especial sua eficácia, a partir das avaliações de larga escala.

Os dados analisados são oriundos do Projeto Geres, um estudo longitudinal de tipo painel que, no período de 2005-2008, coletou dados dos mesmos alunos (2º ao 5º ano) de uma amostra de 312 escolas em cinco grandes cidades brasileiras, em que foram medidas as proficiências em Leitura e Matemática de 35.538 alunos e coletadas informações de contexto desses em cinco diferentes medições.

Para o estudo foram selecionados os alunos que permaneceram na mesma escola durante os quatro anos de escolarização e que tinham disponíveis informações coletadas através de um questionário, o que permitiu o cálculo de seu NSE. Para a análise, os alunos foram agrupados em dez decis em função do seu NSE, em ordem crescente, como mostra a Tabela 1:

Nos Gráficos 1A e 1B5 5 . As escalas usadas nos gráficos são diferentes para facilitar a visualização, algo que pode ser feito, uma vez que as escalas em Matemática e Leitura não são comparáveis, isto é, uma proficiência de 200 em matemática não tem o mesmo significado pedagógico em Leitura. vê-se as proficiências médias desses dez grupos de alunos nas cinco medições, de forma que o valor agregado entre duas medições sucessivas indica o crescimento médio dos alunos de cada grupo (decis) durante um ano de escolarização.

Desses dois gráficos constata-se que a posição do grupo em função da proficiência inicial define a posição do mesmo grupo na proficiência final, bem como que o NSE é fator determinante para a proficiência inicial dos alunos.

Nesse mesmo estudo, o pesquisador fez um reagrupamento dos alunos, usando como critério a dependência administrativa da escola na qual o aluno está matriculado, cujos resultados estão apresentados nos Gráficos 2A e 2B.

Pelos gráficos pode-se ver que as curvas de desenvolvimento continuam acompanhando o NSE, uma vez que, em geral, os alunos com maior NSE encontram-se matriculados nas escolas privadas e especiais (esta última possui seleção para admissão de seus alunos, sendo exemplo as escolas militares e federais) e os alunos com menor NSE se encontram matriculados em escolas públicas, tanto municipais como estaduais. Essa constatação é confirmada através da análise do Gráfico 3, que mostra a distribuição do NSE dos alunos de cada uma das diferentes dependências administrativas.

Dessa forma, se uma escola eficaz for aquela cujos alunos obtenham melhor desempenho médio em exames de proficiência, em geral, entrarão nessa categoria as escolas especiais e aquelas pertencentes à rede privada. No entanto, dado o exposto, essa classificação se deveria mais pelo fato delas terem matriculado os alunos com NSE mais alto do que, necessariamente, por um melhor trabalho desenvolvido em seu interior.

Dessas evidencias percebe-se a incoerência, e até o equívoco, dos processos meritocráticos baseados em indicadores dessa natureza. Isso porque:

A média do desempenho cognitivo dos alunos de uma dada escola não pode ser tomada como uma medida de sua qualidade, já que escolas diferentes têm alunos com perfis socioeconômicos muito diferentes e é amplamente conhecida a influência do nível socioeconômico no desempenho dos alunos da educação básica. (SOARES; ANDRADE, 2006, p. 118)

Logo, omitir a utilização do NSE na constituição dos índices é, minimamente, desconsiderar a influência dos fatores extraescolares e o real trabalho desenvolvido pela escola. Contudo, a inclusão do NSE no Ideb eliminaria o problema?

Ao supormos a efetivação da inserção do NSE no Ideb, teríamos dado um passo à frente na questão de considerar os resultados de desempenho em relação ao contexto socioeconômico das famílias atendidas. Todavia, ainda não poderíamos tomar o índice como representação única da qualidade da escola ou de sua eficácia. Isso porque tanto a proficiência final média não reflete somente o que foi desenvolvido no processo de escolarização pela instituição, já que os fatores externos continuam a exercer influência, quanto há limitações nos próprios instrumentos de coleta de dados, seja da proficiência ou do próprio NSE.

Quanto à medida da proficiência, há as limitações devidas a pouca abrangência do leque de conhecimentos e ações avaliados, assim como incapacidade de medir, por meio de testes, certos conteúdos importantes à formação dos estudantes (ALMEIDA; BETINI, 2012). Já com relação à medida de NSE há limitações tanto por sua composição (que indicadores utilizar para a elaboração do índice socioeconômico ISE), quanto em operacionalização (devido aos conceitos de validade e confiabilidade inerentes à coleta de dados por meio de questionário).

Analisando o problema da composição do NSE, Alves e Soares (2009, p. 2) afirmam:

O nível socioeconômico aparece em inúmeros estudos como variável explicativa ou de controle para a análise de diversos fenômenos sociais. No entanto, não há um consenso na literatura sobre sua conceituação, bem como sobre como medi-lo nas pesquisas empíricas. Há vários aspectos relacionados ao NSE que vêm merecendo debate entre os cientistas sociais. Por exemplo, a sua base de conceituação teórica, o tipo de medida se contínua ou categórica , os fatores a serem considerados na produção da medida se variáveis isoladas ou em forma de um índice , a definição de um esquema de classificação das variáveis consideradas e a importância relativa do pai e da mãe para a definição do NSE das famílias.

Em relação ao problema de operacionalização, segundo Selltiz et al. (1974), quando um instrumento de medida é aplicado em uma amostra de pessoas a variação encontrada no conjunto de respostas individuais é provocada por diversos fatores. Parte dessa variação é desejada e esperada, afinal há diferenças entre as pessoas, mas a outra parte deve-se a problemas metodológicos inerentes à coleta dos dados. Essa segunda parte, indesejada, pode se originar por dois tipos de problemas: o primeiro, denominado de erro amostral, associado aos procedimentos para a definição da amostra que irá responder aos questionários. O segundo, denominado erro não amostral, associado a problemas de diferentes naturezas inerentes ao instrumento, sendo o principal aquele ligado ao viés, problema que cada um dos itens dos questionários pode trazer.

O viés é um aspecto de difícil verificação e decorre de limitações tanto na elaboração dos itens, quanto na aplicação dos questionários. Na elaboração dos itens o viés pode se dar a partir das escolhas feitas pelo elaborador do instrumento, as quais, se não forem bem dimensionadas, podem acarretar certo direcionamento das respostas. Na aplicação dos questionários este viés pode ocorrer a partir da interpretação da questão pelo respondente ambiguidade e falta de clareza; da dificuldade de acesso à memória quando o respondente precisa saber/lembrar determinadas coisas para responder corretamente à questão; e pela captação de respostas distorcidas devido a constrangimentos, julgamentos e inferências que os respondentes podem ter diante dos itens do questionário (GUNTHER, 2003).

Neste aspecto, Almeida (2002, p. 339) mostra que "os efeitos do posicionamento de uma pergunta no questionário sobre os resultados da pesquisa podem ser muito grandes, e até mesmo invalidar os resultados da pesquisa". Além disso,

[...]apesar de carregarem historicamente uma imagem de precisão e exatidão, os estudos quantitativos contêm em si próprios elementos de subjetividade e, portanto, possuem precisão e exatidão relativas. Estes espaços de subjetividade e de interpretação de limites abrem possibilidade para a introdução da visão de mundo (ideologia) do pesquisador e sua concepção de educação, às vezes de forma não consciente, que afetam a seleção e os critérios de construção das variáveis, os quais nem sempre acompanham o relatório final das pesquisas. (FACCENDA; DALBEN; FREITAS, 2011, p. 265)

Nesta perspectiva, a inclusão do NSE no Ideb, embora seja uma importante contribuição para a tomada deste índice como indicador para a análise das escolas, por si só não representa a solução do problema do seu uso como aferidor de qualidade. Isso porque, ao ser interpretado como reflexo do trabalho desenvolvido pelas escolas, o Ideb possui limitações postas pelo próprio delineamento que não o viabilizam como tal, podendo ser, por isso mesmo, apenas um dos indicadores da avaliação das escolas, mas de forma alguma o único.

Possibilidades de análise do trabalho das escolas e de sua eficácia: aprofundando o debate

No campo da avaliação educacional, a possibilidade da associação da eficácia escolar a diferentes resultados oriundos dos exames baseados em testes padronizados é um problema, à medida que diferentes formas de medir levam a resultados diferentes, o que evidencia a fragilidade da elaboração de listas de ranqueamento e, consequentemente, do uso meritocráticos desses resultados.

Estimando os efeitos do NSE na proficiência dos alunos, Dalben (2012) trouxe evidências acerca da impossibilidade de se tomar como sinônimo de qualidade escolar os índices de forma descontextualizada e a partir de medições transversais, tipicamente usadas nas medições de larga escala.

Analisando a questão, mesmo que a eficácia escolar fosse medida a partir de um parâmetro que considerasse o ponto de partida do estudante, tomando como uma escola eficaz aquela cujos alunos tivessem o maior ganho de proficiência desde a entrada na escola (ou seja, o maior valor agregado),6 6 . A determinação do valor agregado é obtida através da diferença aritmética entre duas medidas de proficiência de um mesmo aluno, o que é possível apenas em coleta de dados longitudinais em painel. Vale apontar que, ao falarmos em alto ou baixo valor agregado, não estamos necessariamente nos remetendo à análise da qualidade da escola, já que esta requereria mais parâmetros para análise. a análise da eficácia escolar permaneceria frágil, já que durante o período de escolarização o valor agregado não se deve apenas à influência do estabelecimento de ensino, uma vez que os outros espaços sociais do aluno continuam também a formá-lo. Esta análise insere um novo conceito no debate: o efeito-escola, que, para Murillo-Torrecilla (2005, p. 32), é "[...] el porcentaje de variación en el rendimiento de los alumnos debido a las características procesuales del centro en el que están escolarizados. Y se mediría como un porcentaje de varianza".

Debatendo esta questão, Ferrão e Couto (2012, p. 8) salientam que:

Alguns dos estudos que mostram evidência da ocorrência da eficácia diferencial (differential school effects), isto é, o efeito-escola pode ser influenciado pelo perfil do aluno à entrada na escola (students' intake), revelam ainda que a composição da população discente (school composition effects) também influencia os resultados atingidos. Estes colocam em evidência o fato do desempenho individual dos alunos de uma escola se encontrar associado ao perfil dominante dos seus alunos (aggregated students' intake). Sammons argumenta (1999, p. 102) "disadvantaged students in the most effective schools can end up with higher achievements than their advantaged peers in the less effective schools".7 7 . Alunos carentes de escolas mais eficazes podem obter melhores resultados do que os outros, mais favorecidos, matriculados em escolas menos eficazes. Caso a "desvantagem" dos alunos seja de natureza socioeconômica, o efeito pode ser estudado na perspectiva da equidade social da escola.

Um aspecto a se destacar é que a proficiência dos alunos sofre influência não só da família, mas também do NSE médio da escola, tanto na entrada do aluno, quanto durante todo o seu período de escolarização.

Processando os dados do Projeto Geres a partir de modelos lineares hierárquicos (HLM) e selecionando para a amostra alunos que possuem duas medidas consecutivas de proficiência, com informações acerca do NSE disponíveis, analisaram-se os fatores que interferem de maneira estatisticamente significativa no valor agregado.8 8 . Os valores apresentados indicam uma média das 229 escolas estudadas nas quatro diferentes redes de ensino (especial, privada estadual e municipal) de quatro diferentes cidades brasileiras (Belo Horizonte, Campinas, Campo Grande e Rio de Janeiro), já que, apesar da cidade de Salvador fazer parte do Projeto Geres, ela foi excluída deste estudo por não ter participado da última aplicação de testes, quando as informações sobre NSE foram coletadas.

Entre os resultados, além de se confirmar que tanto o NSE do aluno, quanto o médio da escola influenciam na proficiência, ainda se evidencia que o NSE médio das escolas o faz de forma diferente para alunos com diferentes proficiências de entrada na escola.

Como mostra a Tabela 3, pode-se perceber que para cada unidade de NSE do aluno, sua proficiência final em cada ano de escolarização, em média, é acrescida de 2,2 pontos, com exceção do terceiro ano de escolarização do estudo (antiga terceira série), cujo valor é acrescido de 0,5 ponto; já o NSE médio da escola influencia de forma diferente os alunos com diferentes proficiências iniciais.

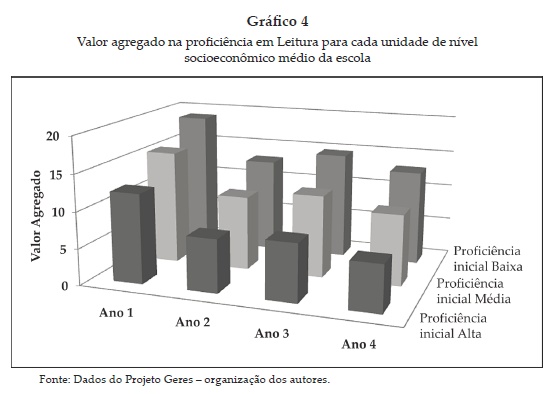

O Gráfico 4 representa esses valores evidenciando que, em média, os alunos com proficiência baixa se beneficiam mais quando o NSE da escola aumenta.

Ao observar essas evidências e as discussões aqui empreendidas, parece razoável que uma escola identificada como eficaz seria:

[...] aquella que promueve de forma duradera el desarrollo integral de cada uno de sus alumnos más allá de lo que sería imprevisible teniendo en cuenta su rendimiento inicial y la situación social, cultural y económica de sus familias. (MURILLO-TORRECILLA et al., 2007, p. 83)

Análise contemplada também por Mortimore (1998, p. 319, tradução nossa), quando afirma que uma escola eficaz "[...] é aquela em que o progresso do aluno vai além do que seria esperado, levando em consideração as suas características à entrada na escola [...]".

Nesta perspectiva, olhar para o trabalho da escola longitudinalmente, a partir do que foi sendo agregado pelo aluno, permite uma análise que possa instrumentalizar a instituição para realizar de maneira mais efetiva seu trabalho.

Algumas das escolas onde os alunos atingem níveis de desempenho elevado pouco contribuem para esse desempenho: tendencialmente, escolas frequentadas por alunos com elevado nível de desempenho à entrada (escolas seletivas) e provenientes de grupos sociais favorecidos. Em contrapartida, as escolas que recebem alunos com baixo desempenho e onde, no final do período sob avaliação, o desempenho se mantém aquém da meta educativa estabelecida, podem, apesar disso, ter contribuído fortemente para alavancar a aprendizagem desses alunos e, portanto, apresentam elevado valor acrescentado. A sua contribuição não está refletida no indicador de status, mas sim no indicador de valor acrescentado. (FERRÃO; COUTO, 2012, p. 8)

O Nacional Research Council and National Academy of Education (2010) propôs uma organização, representada na Figura 1, a qual permite o estabelecimento da relação entre a proficiência final média (rendimento) e o valor agregado médio, permitindo uma observação diferenciada das escolas.

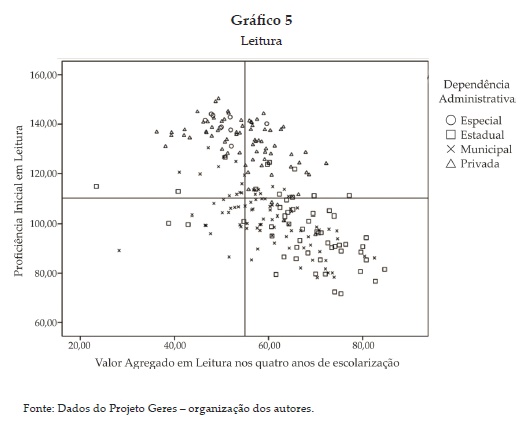

Usando este modelo para o banco de dados deste estudo, pode-se ver no Gráfico 5 a distribuição das escolas confrontando a proficiência média e o valor agregado médio obtidos por seus alunos em Leitura.

Como se pôde observar, no Quadrante I (alto rendimento e alto valor agregado) há uma predominância de escolas privadas. No Quadrante II (alto rendimento e baixo valor agregado) predominam as escolas especiais e privadas. Já no Quadrante IV (baixo rendimento e alto valor agregado) encontram-se as escolas estaduais e municipais e, no Quadrante III (baixo rendimento e baixo valor agregado), predominam as escolas municipais.

Com o comportamento observado no gráfico, confirma-se a não possibilidade de associação direta entre os rendimentos divulgados a partir das avaliações em larga escala conduzidas no Brasil (transversais ou seccionais) e a definição de boas escolas (escolas eficazes), já que muito do rendimento medido se deve ao nível de entrada do aluno e a seu NSE, não sendo especificamente evidência do trabalho desenvolvido nas instituições.

Evidencia-se que, mesmo com baixo desempenho médio, as escolas estaduais e municipais conseguem se destacar em relação ao valor agregado, o que, associado à análise anteriormente apresentada acerca da relação explícita entre desempenho médio, nível de entrada de alunos e seu NSE, demonstra que mesmo em situações mais adversas, em muitas escolas públicas, os alunos se desenvolvem (observando o valor agregado e não o desempenho médio) tanto quanto em algumas escolas privadas.

Todavia, este comportamento é diferente no estudo em Matemática, como é explicitado no gráfico a seguir.

Pode-se observar que há uma distribuição predominantemente entre os Quadrantes I e III, sendo que no primeiro prevalecem as escolas privadas e especiais e no terceiro as escolas estaduais e municipais.

Esse comportamento pode tanto evidenciar uma maior eficácia das escolas privadas e especiais em relação às públicas no tocante à Matemática, quanto uma prática pouco voltada ao ensino desta disciplina nas escolas públicas, havendo certa prioridade na área da leitura.

Corroborando a análise da questão, parece que houve certa priorização da área da alfabetização em detrimento da matemática nas escolas públicas. Segundo declaração da secretária de Educação Básica do Ministério da Educação, Maria do Pilar Lacerda:

[...] nos últimos anos os governos municipais, estaduais e federal, além das próprias escolas, focaram mais a questão da alfabetização nos primeiros anos do ensino fundamental, quando 56% têm o domínio adequado da leitura, o que pode explicar o resultado inferior em matemática. (UOL, 2011)

Nesta perspectiva, embora valha ressaltar que, de acordo com os dados obtidos, fica evidente que o aprendizado em matemática nas escolas públicas necessita ser reorganizado de forma a potencializar o desenvolvimento adequado dos estudantes nesta área do conhecimento, nos parece que a análise dos dados para Matemática necessita ser mais aprofundada para evitarmos conclusões precipitadas.

De forma geral, pela discussão exposta e pelos dados analisados, reforça-se a indicação de que a eficácia da escola não pode ser avaliada por um único indicador, seja ele qual for, e que pensar no trabalho da escola, nas variáveis que o influenciam e, por consequência, na qualidade que ela oferta é, sem dúvida, tarefa árdua e complexa e que necessita se voltar a diversos aspectos, além do desempenho medido pelos testes aplicados aos alunos.

Algumas considerações

Nossas reflexões não pretendem, em hipótese alguma, fazer uma oposição às avaliações externas, mas evidenciar que seus resultados podem ajudar de forma mais efetiva na melhoria da qualidade educacional, se utilizados índices mais amplos que deem conta de outras dimensões da questão da qualidade, assim como instrumentos de medida com desenho mais apropriado ao fenômeno avaliado.

Ao se analisar a utilização que vem sendo feita do Ideb procurou-se explicitar os possíveis problemas enfrentados para a construção e "consumo" dos dados gerados, tanto pela não abrangência em seu desenho metodológico dos aspectos externos à escola, em especial o NSE dos alunos, quanto pela aparente incapacidade de percepção dos reais limites/possibilidades que tem o indicador.

A utilização dos resultados das avaliações em larga escala no Brasil tem se apresentado muito como sinônimo do trabalho desenvolvido pelas escolas, mas não se demonstra benéfica, tendo em vista que grande parte do desempenho não pode ser atribuída somente ao trabalho da/na escola.

Considerando-se a importância das avaliações em larga escala como instrumento de informação sobre o desempenho dos alunos e escolas e não sendo possível assumir esses resultados de desempenho como retrato da eficácia ou não dessas instituições, assume-se como alternativa de medição a análise a partir do valor agregado, que, embora ainda tenha suas limitações e não possa ser tomado como retrato fiel do trabalho da escola, ao isolar o nível de aprendizagem anterior ao início da escolarização, possibilita uma análise mais fidedigna do fenômeno.

Nesta perspectiva, vale ressaltar que a partir do que foi discutido e considerando o conceito de eficácia escolar exposto, acredita-se que não apenas o modelo que vem sendo adotado é inapropriado para a compreensão e melhoria do trabalho desenvolvido nas escolas, como evidencia a impossibilidade da adoção de processos meritocráticos em que as escolas são ranqueadas a partir do Ideb e responsabilizadas de forma unívoca por seus resultados, sem que os aspectos que o compõem sejam devidamente analisados e considerados para a observação do trabalho desenvolvido.

Percebe-se, neste viés, que não apenas o modelo da avaliação em larga escala deveria ser outro, como, para que as escolas pudessem tomar seus resultados como propulsores da melhoria de sua qualidade, estas deveriam participar de processos de avaliação como, por exemplo, o modelo de Avaliação Institucional Participativa (FREITAS et al., 2009), que almeja o envolvimento dos diferentes segmentos da escola, assim como de pessoas de seu entorno social interessadas na melhoria da instituição, na reflexão sobre seus problemas e potencialidades, de forma a avançar nas questões educativas.

Em relação especificamente ao Ideb, nos chama a atenção a forma pela qual ele é apresentado (e divulgado) para a população, em que a escola aparece como única responsável pelo desempenho de seus alunos, sem qualquer vinculação à relação deste com seu entorno social, com a rede de ensino à qual pertence e com as políticas públicas às quais está, direta ou indiretamente, submetida, pois tal isolamento pode gerar a ideia de que a escola e seus profissionais são, sozinhos, responsáveis pelos resultados obtidos nas avaliações externas, induzindo de forma equivocada à ideia da perda da influência do entorno social e das políticas públicas sobre os resultados dessas avaliações, tendo como consequência a desresponsabilização, de forma branda, do sistema educativo e social mais amplo sobre tais resultados.

Esse percurso é perigoso, pois acaba trazendo um movimento de responsabilização unidirecional da escola e de seus profissionais sem que a eles sejam dadas as condições objetivas de melhoria da qualidade do ensino ofertado à população. Como alerta Freitas (2003, p. 35):

[...] a escola é um pouco mais complexa do que um conjunto de variáveis a serem manipuladas, e os valores dessas variáveis são de difícil estabilização e transferência para outras situações. [...] Isso não significa dizer que nada há a ser aprendido com os estudos quantitativos e com as avaliações de larga escala. Significa que devemos colocá-los em seu devido lugar.

Nesse sentido, embora o Ideb seja um instrumento promissor para a análise das escolas como um dos indicadores a ser considerado em sua avaliação, não consegue, sozinho, ainda que abrangendo o NSE em seu delineamento, apreender a especificidade de cada uma das instituições analisadas ou sua eficácia, já que, por melhores que sejam as tecnologias utilizadas, sempre estarão sujeitas aos limites do próprio instrumento, estando condenadas a ser uma pálida e imperfeita foto da realidade escolar.

Notas

Recebido em 17 de junho de 2013.

Aprovado em 22 de agosto de 2013.

- ALMEIDA, A.C. O efeito do contexto e posição da pergunta no questionário sobre o resultado da medição. Opinião Pública, Campinas, v. 8, n. 2, 2002.

- ALMEIDA, L.C.; BETINI, G.A. Consequências do uso de testes padronizados nas avaliações escolares. In: ENCONTRO REGIONAL DA ANPAE SUDESTE, 8.; ENCONTRO ESTADUAL DA ANPAE-SP, 7 Campinas, 2012.

- ALVES, M.T., SOARES, J.F. Medidas de nível socioeconômico em pesquisas sociais: uma aplicação aos dados de uma pesquisa educacional. Opinião Pública, Campinas, v. 15, n. 1, jun. 2009.

- BOURDIEU, P. Escritos de Educação Petrópolis: Vozes, 1998.

- BROOKE, N.; SOARES, J.F. (Org.). Pesquisa em eficácia escolar: origem e trajetórias. Belo Horizonte: Editora da UFMG, 2008.

- CASASSUS, J. Uma nota crítica sobre a avaliação estandardizada: a perda de qualidade e a segmentação social. Sísifo/ Revista de Ciências da Educação, n. 9, maio/ago. 2009.

- CÉSAR, C.C.; SOARES, J.F. Desigualdades acadêmicas induzidas pelo contexto escolar. Revista Brasileira de Estudos Populacionais, Rio de Janeiro, v. 18, n. 1/2, p. 97-110, jan./dez. 2001.

- COLEMAN, J.S. et al. Equality of educational opportunity Washington, DC: Office of Education and Welfare, 1966.

- CURY, C.R. A educação básica no Brasil. Educação & Sociedade, Campinas, v. 23, n. 80, set. 2002.

- DALBEN, A. Avaliações de desempenho do aluno para a atribuição de sanções e bonificações à escola e ao professor. In: ENCONTRO NACIONAL DE DIDÁTICA E PRÁTICAS DE ENSINO, 16. Campinas: Endipe, 2012.

- DI CARLO, M. Teachers matter, but so do words. Blog July 14, 2010. Disponível em: <http://shankerblog.org/?p=74>. Acesso em: maio 2013.

- EURYDICE. Red Europea de Información en Educación and Comisión Europea. Dirección General de Educación y Cultura. Evaluación De Los Centros De Enseñanza Obligatoria en Europa Bruselas: Eurydice, Unidad Europea, 2004.

- FACCENDA, O.; DALBEN, A.; FREITAS, L.C. Capacidade explicativa de questionários de contexto: aspectos metodológicos. Revista Brasileira de Estudos Pedagógicos, v. 92, n. 231, 2011.

- FERRÃO, M.E.; COUTO, A. Indicador de valor acrescentado e tópicos sobre consistência e estabilidade: uma aplicação ao Brasil. 2012. (No prelo).

- FERRÃO, M.E.; FERNANDES, C. A escola brasileira faz diferença? Uma investigação dos efeitos da escola na proficiência em matemática dos alunos da 4Ş série. In: FRANCO, C. (Org.). Avaliação, ciclos e promoção na educação. Porto Alegre: Artmed, 2001.

- FREITAS, L.C. et al. Avaliação educacional: caminhando pela contramão. Petrópolis: Vozes, 2009.

- FREITAS, L.C. Responsabilização, meritocracia e privatização: conseguiremos escapar ao neotecnicismo? In: SEMINÁRIO DE EDUCAÇÃO BRASILEIRA, 3. Campinas: Cedes, 2011.

- FREITAS, L.C. Eliminação adiada: o ocaso das classes populares no interior da escola e a ocultação da (má) qualidade do ensino. Educação & Sociedade, Campinas, v. 28, n. 100 - Especial, p. 965-987, out. 2007.

- FREITAS, L.C. Ciclos, seriação e Avaliação: confronto de lógicas. São Paulo: Moderna, 2003.

- FREITAS, L.C. et al. Dialética da inclusão e da exclusão: por uma qualidade negociada e emancipadora nas escolas. In: GERALDI, C.G.; RIOLFI, C.R.; GARCIA, M.F. Escola viva: elementos para a construção de uma educação de qualidade social. São Paulo: Mercado de Letras, 2004.

- GHUNTHER, H. Como elaborar um questionário. Brasília, DF: Laboratório de Psicologia Ambiental, 2003.

- HORTA NETO, J.L. Limites para a utilização dos resultados de avaliações nacionais externas estandardizadas: caso da utilização Saeb por um ente federado brasileiro. Disponível em: <http://www.anpae.org.br/iberolusobrasileiro2010/cdrom/53.pdf>. Acesso em: nov.2010.

- INEP-MEC. Índice de Desenvolvimento da Educação Básica (Ideb). Texto para Discussão, Brasília, DF, n. 26. Disponível em: <www.inep.gov.br>. Acesso em: maio 2013.

- KELLAGHAN, T.; GREANEY, V. Monitoring the learning outcomes of education systems Washington, DC: World Bank Documents, 1996.

- MACHADO, C. Avaliação externa e gestão escolar: reflexões sobre usos dos resultados. Revista Ambiente e Educação, v. 5, n. 1, p. 70-82, jan./jun. 2012.

- MADAUS, G.; RUSSEL, M.; HIGGINS, J. The paradoxes of high stakes testing: how they affect students, their parents, teachers, principals, schools, and society. Charlotte, NC: Information Age Publishing, 2009.

- MINISTÉRIO DA EDUCAÇÃO. Índice de Desenvolvimento da Educação Básica - Ideb. Disponível em: <http://portal.mec.gov.br/index.php?Itemid=336>. Acesso em: jan. 2013.

- MORTIMORE, P. The road to improvement: reflections on school effectiveness. Netherlands: Swets & Zeitlinger, 1998.

- MURALIDHARAN, K.; SUNDARARAMAN, V. Teacher incentives in developing countries: experimental evidence from India. Harvard University, 2006. (mimeo.). Disponível em: <http://people.virginia.edu/~sns5r/microwkshp/incentives.pdf>. Acesso em: maio 2013.

- MURILLO-TORRECILLA, F.J. ¿Importa la escuela? Una estimación de los efectos escolares en España. Tendencias Pedagógicas, n. 10, p. 29-45, 2005.

- MURILLO-TORRECILLA, F.J. et al. Investigación iberoamericana sobre eficacia escolar. Bogotá: Convenio Andrés Bello, 2007.

- NATIONAL RESEARCH COUNCIL AND NATIONAL ACADEMY OF EDUCATION. Getting value out of value-added: report of a Workshop. In: BRAUN, H.; CHUDOWSKY, N.; LOENIG, J. (Ed.). Committee on Value-Added Methodology for Instructional Improvement, program Evaluation, and Educational Accountability. Center for Education, Division of Behavioral and Social Sciences and Education. Washington, DC: The National Academies Press, 2010.

- NEAL, D.; SCHANZENBACH, D.W. Left behind by design: proficiency counts and test-based accountability. The Review of Economics and Statistics, Massachusetts, p. 263-283, maio 2010.

- NICHOLS, S.L.; BERLINDER, D.C. Collateral damage: how high-stakes testing corrupts America's schools. Cambridge, MA: Harvard Education Press, 2007.

- PLOWDEN COMMITTEE. Chidren and their primary scholl London: HMSO, 1967.

- RAVITCH, D. The death and life of the great American school system: how testing and choice are undermining education. New York: Basic Books, 2010.

- SELLTIZ, C. et al. Métodos de pesquisa nas relações sociais São Paulo: EPU, 1974.

- SOARES, J.F. IDEB na Lei? Simon's site, 13 jul. 2011. Disponível em: <http://www.schwartzman.org.br/sitesimon/?p=2352&lang=pt-br>. Acesso em: jun. 2013.

- SOARES, J.F. O efeito da escola no desempenho cognitivo de seus alunos. Reice: Revista Eletrónica Iberoamericana sobre Calidad, Eficacia y Cambio en Educación, v. 2, n. 2, p. 83-104. 2004.

- SOARES, J.F.; ANDRADE, R.J. Nível socioeconômico, qualidade e eqüidade das escolas de Belo Horizonte. Ensaio: Avaliação e Políticas Públicas Educacionais, Rio de Janeiro, v. 14, n. 50, p. 107-126, jan./mar. 2006.

- UOL. Escolas privilegiam alfabetização do que o ensino da matemática, avalia secretária do MEC. UOL/Educação, 25 ago. 2008. Disponível em: <http://educacao.uol.com.br>. Acesso em: 14 out. 2012.

Datas de Publicação

-

Publicação nesta coleção

06 Mar 2014 -

Data do Fascículo

Dez 2013

Histórico

-

Recebido

17 Jun 2013 -

Aceito

22 Ago 2013