Resumos

Doze universitários, distribuídos em quatro grupos, clicaram com o mouse sobre um botão na tela de um computador. Os participantes dos Grupos 1 e 3 foram expostos à seqüência FR - DRL - FI e os dos Grupos 2 e 4 à seqüência DRL - FR - FI. Os reforçadores foram pontos trocados por dinheiro (Grupos 1 e 2) ou pontos apenas (Grupos 3 e 4). Efeitos de histórias recentes em FI foram preponderantes quando pontos foram trocados por dinheiro. História, recente ou remota, de DRL afetou o comportamento subseqüente principalmente quando o reforçador consistia de pontos apenas. Sugere-se que o reforçador empregado modula efeitos de história em FI e que sua manipulação pode esclarecer discrepâncias entre humanos e não-humanos sob programas de reforço.

esquemas de reforçamento; história comportamental; tipo de reforçador; humanos

Twelve undergraduates in four groups responded by clicking on a button presented on a computer screen. Participants of Groups 1 and 3 were exposed to the sequence FR - DRL - FI and those of Groups 2 and 4 to the sequence DRL - FR - FI. Reinforcers were points exchanged by money (Groups 1 and 2) or points only (Groups 3 and 4). Effects of recent histories over FI performance were consistently observed when points were exchanged by money. DRL histories, recent or remote, affected subsequent performance especially when reinforcers were points only. Results suggest that the reinforcer that is used modulates history effects over FI performance and that its manipulation can clarify some discrepancies between human and non-human in schedules of reinforcement.

schedules of reinforcement; behavioral history; type of reinforcer; humans

Efeitos do reforçador empregado em história de reforço recente e remota1 1 Este artigo é derivado da dissertação do primeiro autor, sob orientação do último autor, apresentada em 2007 no programa de mestrado em Análise do Comportamento da Universidade Estadual de Londrina. Rodrigo Cruvinel Salgado foi bolsista CAPES durante o mestrado. Os autores agradecem a colaboração do professor Dr. Marcelo Frota Benvenuti pela leitura cuidadosa da primeira versão deste artigo e suas sugestões. 2 Endereço para correspondência: Universidade Estadual de Londrina - Centro de Ciências Biológicas, Departamento de Psicologia Geral e Análise do Comportamento. Rodovia Celso Garcia Cid, Km 380. Caixa Postal (6001)86051 - 990. Londrina, Paraná. Fone: (43) 3371-4227; (43) 9928-3335. E-mail: caecosta@uel.br

Effects of the type of reinforcer in recent and remote reinforcement history

Rodrigo Cruvinel SalgadoI; Carlos Renato Xavier CançadoII; Carlos Eduardo CostaIII, 2 1 Este artigo é derivado da dissertação do primeiro autor, sob orientação do último autor, apresentada em 2007 no programa de mestrado em Análise do Comportamento da Universidade Estadual de Londrina. Rodrigo Cruvinel Salgado foi bolsista CAPES durante o mestrado. Os autores agradecem a colaboração do professor Dr. Marcelo Frota Benvenuti pela leitura cuidadosa da primeira versão deste artigo e suas sugestões. 2 Endereço para correspondência: Universidade Estadual de Londrina - Centro de Ciências Biológicas, Departamento de Psicologia Geral e Análise do Comportamento. Rodovia Celso Garcia Cid, Km 380. Caixa Postal (6001)86051 - 990. Londrina, Paraná. Fone: (43) 3371-4227; (43) 9928-3335. E-mail: caecosta@uel.br

IUniversidade Estadual de Londrina - UEL Centro Universitário Vila Velha - UVV

IIWest Virginia University

IIIUniversidade Estadual de Londrina - UEL

RESUMO

Doze universitários, distribuídos em quatro grupos, clicaram com o mouse sobre um botão na tela de um computador. Os participantes dos Grupos 1 e 3 foram expostos à seqüência FR - DRL - FI e os dos Grupos 2 e 4 à seqüência DRL - FR - FI. Os reforçadores foram pontos trocados por dinheiro (Grupos 1 e 2) ou pontos apenas (Grupos 3 e 4). Efeitos de histórias recentes em FI foram preponderantes quando pontos foram trocados por dinheiro. História, recente ou remota, de DRL afetou o comportamento subseqüente principalmente quando o reforçador consistia de pontos apenas. Sugere-se que o reforçador empregado modula efeitos de história em FI e que sua manipulação pode esclarecer discrepâncias entre humanos e não-humanos sob programas de reforço.

Palavras-chave: esquemas de reforçamento; história comportamental; tipo de reforçador; humanos.

ABSTRACT

Twelve undergraduates in four groups responded by clicking on a button presented on a computer screen. Participants of Groups 1 and 3 were exposed to the sequence FR - DRL - FI and those of Groups 2 and 4 to the sequence DRL - FR - FI. Reinforcers were points exchanged by money (Groups 1 and 2) or points only (Groups 3 and 4). Effects of recent histories over FI performance were consistently observed when points were exchanged by money. DRL histories, recent or remote, affected subsequent performance especially when reinforcers were points only. Results suggest that the reinforcer that is used modulates history effects over FI performance and that its manipulation can clarify some discrepancies between human and non-human in schedules of reinforcement.

Keywords: schedules of reinforcement; behavioral history; type of reinforcer; humans

Eventos ocorridos no passado parecem afetar a vida atual de algum modo. Do ponto de vista behaviorista radical, o organismo tende a se comportar de maneira semelhante ao que foi anteriormente reforçado (Skinner, 1953/1993; 1974; 1981). Desse modo, analistas do comportamento formulam uma explicação eminentemente histórica para as ações dos organismos, como alternativa às explicações que concebem o comportamento como produto de variáveis existentes, ou supostamente existentes, em diferentes níveis observacionais (Baum, 2005/2006; Chiesa, 1994; Costa, Cirino, Cançado & Soares, 2009; Ferster & Skinner, 1957; Wanchisen, 1990).

De especial interesse para o presente estudo são os efeitos de histórias remota e recente sobre o comportamento atual dos organismos, particulamente o de humanos em programas de reforço em intervalo-fixo (FI). As designações "recente" e "remota" são arbitrariamente estabelecidas a partir de uma exposição seqüencial dos organismos aos programas de reforço em fases experimentais que precedem a condição de teste do estudo (e.g., Cole, 2001; LeFrancois & Metzger, 1993; Ono & Iwabuchi, 1997; Okouchi, 2007; Weiner, 1969; 1970). Por exemplo, o organismo é exposto às seqüências reforço diferencial de baixas taxas (DRL) - razão fixa (FR) - intervalo fixo (FI) ou, alternativamente, a FR - DRL - FI, em fases sucessivas. No primeiro caso, o programa de reforço DRL é parte da história remota e FR da história recente em relação ao FI. Na segunda seqüência, FR é parte da história remota e DRL é parte da história recente.

Weiner (1969, Experimento 5) analisou efeitos de histórias recente e remota sobre o comportamento subseqüente de humanos. Três participantes foram expostos à seqüência DRL - FR - FI - FI-custo e três outros à seqüência FR - DRL - FI - FI-custo. Sob o FI-custo os participantes recebiam 100 pontos para a primeira resposta emitida após o intervalo definido pelo parâmetro do FI e perdiam um ponto para cada resposta emitida durante o intervalo entre reforços (IRI). Os participantes recebiam dinheiro por hora de participação no experimento e a conseqüência contingente ao desempenho era apenas os pontos. O desempenho da maioria dos participantes foi de baixas taxas em FI, independentemente da história de DRL ser recente ou remota em relação ao FI. Resultados similares foram apresentados por Weiner (1970).

LeFrancois e Metzger (1993) relataram resultados diferentes, em um estudo realizado com ratos. Os ratos do Grupo 1 foram expostos à sequência DRL - FI e os do Grupo 2, à sequência DRL - FR - FI. Os ratos do Grupo 1 emitiram baixas taxas de respostas em FI, ao contrário daqueles do Grupo 2, que emitiram altas taxas de respostas em condição semelhante. As autoras argumentaram que seus achados foram inconsistentes com aqueles de outras pesquisas que tiveram humanos como participantes (e.g., Weiner, 1969, 1970). A exposição ao programa de DRL produziu um desempenho em baixa taxa apenas quando precedia imediatamente a condição de FI (i.e., apenas quando era parte da história recente). Quando a história recente era de FR, observou-se um padrão de taxas altas de respostas na condição subseqüente em FI. As autoras sugeriram que esta diferença entre desempenhos de humanos e não-humanos poderia ser atribuída a variações entre os procedimentos utilizados com cada espécie em diferentes estudos. Por exemplo, nos estudo de Weiner (1969, 1970), luzes de cores diferentes eram correlacionadas aos programas de reforço em diferentes fases experimentais, manipulação que não foi conduzida por LeFrancois e Metzger.

Esta discrepância nos resultados foi analisada por Cole (2001). Dez ratos foram distribuídos em cinco grupos, definidos de acordo com as seguintes seqüências de programas de reforço: (1) FI; (2) DRL - FI; (3) FR - FI; (4) FR - DRL - FI e (5) DRL - FR - FI. O procedimento ao qual os Grupos 4 e 5 foram expostos é de especial interesse, uma vez que neles foram arranjadas condições de história recente e remota cujos efeitos foram analisados sobre o comportamento subseqüente em FI. Durante a exposição inicial ao FI, o comportamento dos ratos do Grupo 4 (FR - DRL - FI) e do Grupo 5 (DRL - FR - FI) foi mais claramente influenciado pela história recente, respectivamente DRL e FR (i.e., os ratos dos Grupos 4 e 5 emitiram, respectivamente, baixas e altas taxas de respostas em FI). Tais resultados são semelhantes àqueles obtidos por LeFrancois e Metzger (1993) e são diferentes daqueles obtidos por Weiner (1969, Experimento 5).

Okouchi (2007) realizou um estudo cujo objetivo geral foi investigar o efeito de histórias remotas sobre o comportamento presente de humanos. Participaram do Experimento 1 seis universitários, distribuídos em dois grupos e a resposta consistiu em tocar um círculo que era apresentado na tela de um computador. Os participantes do Grupo 1 eram expostos a FR enquanto os participantes do Grupo 2 eram expostos a DRL (histórias remotas). Em seguida, todos os participantes eram expostos a reforço diferencial de outro comportamento (DRO) (história recente) e, finalmente, todos eram expostos a FI. Exposição à história remota (FR ou DRL) selecionou altas taxas de respostas em FR e baixas taxas de respostas em DRL. Durante a exposição ao DRO as taxas de respostas foram baixas para todos os participantes e esse padrão persistiu durante a exposição ao FI. Portanto, a taxa de respostas em FI pareceu ter sido mais afetada pela história recente de DRO do que pela história remota de FR ou DRL. No Experimento 2, os participantes foram expostos inicialmente a mesma seqüência de programas de reforço do Experimento 1, e o programa de reforço da fase de teste foi um intervalo-variável (VI). As taxas de respostas durante as fases de história remota e recente foram semelhantes àquelas do Experimento 1, mas dois dos três participantes com história remota de FR apresentaram altas taxas de respostas em VI (i.e., exibiram taxas de respostas semelhante àquelas da fase de história remota).

No Experimento 3, o procedimento arranjado foi semelhante àquele do Experimento 1, mudando-se novamente a fase de teste, que consistiu da seqüência: extinção (EXT), FR e DRL em diferentes sessões, cada uma delas seguida por uma sessão de DRO (um retorno a fase de história recente). As taxas de respostas durante a fase de história remota e recente foram semelhantes àquelas obtidas nos Experimentos 1 e 2. Quando a sessão de teste foi FR ou extinção, a taxa de respostas dos participantes com história remota de FR foi mais alta do que a dos participantes com história remota de DRL. Quando a sessão de teste foi de DRL todos os participantes emitiram baixa taxa de respostas (Okouchi, 2007).

Tomados em conjunto, os resultados do estudo de Okouchi (2007) sugerem que o comportamento de humanos pode ser afetado por histórias remotas, mesmo que elas não sejam de DRL (como nos estudos de Weiner, 1969, 1970). Em adição, história remota ou recente pode exercer efeitos sobre o comportamento atual, a depender da sua semelhança com as contingências presentes em relação ao IRI e ao intervalo entre respostas (IRT). Por exemplo, na transição do DRO para FI, o IRI permaneceu relativamente constante (Experimento 1); na transição do DRO para VI o IRI foi variável (Experimento 2), o que provavelmente contribuiu para efeitos de história recente no Experimento 1 e remota no Experimento 2. No Experimento 3, os efeitos de história recente ou remota provavelmente foram devidos às s ucessivas mudanças nos programas de reforço, e suas semelhanças com os programas de reforço arranjados em fases de história recente e remota em relação aos IRTs. Contudo, permanece a pergunta: quais os fatores responsáveis pelas diferenças nos resultados dos estudos de Weiner (1969; 1970) com humanos e os estudos de LeFrancois e Metzger (1993) e Cole (2001) com ratos?

Assim como LeFrancois e Metzger (1993), Perone, Galizio e Baron (1988) sugeriram que a discrepância nos resultados de pesquisas com humanos e não-humanos podia dever-se a diferenças em aspectos do procedimento que, eventualmente, não estivessem sob adequado controle experimental. Wanchisen e Tatham (1991) afirmaram que, entre outras variáveis, há diferenças na forma de aquisição da resposta operante estudada e no reforçador empregado quando se comparam as pesquisas com humanos e não-humanos. Humanos devem, muitas vezes, pressionar algum botão (resposta que provavelmente ocorre em um contexto extra-experimental) para ganhar pontos ou dinheiro (reforçador condicional generalizado). Por outro lado, ratos, por exemplo, geralmente devem pressionar uma barra (resposta com baixa probabilidade de ocorrer no contexto extra-experimental), cuja conseqüência é água ou comida (reforçador incondicional). Outras diferenças seriam, por exemplo, os critérios de estabilidade do comportamento adotados e o modo como as sessões são programadas (número e duração de cada sessão experimental).

A utilização de reforçadores variados tem produzido, também, resultados contraditórios. Em alguns estudos reforçadores diferentes parecem produzir desempenhos distintos sob a mesma contingência de reforço enquanto em outros estudos o desempenho dos organismos parece ser mais afetado pela contingência de reforço programada do que pelo reforçador empregado (e.g., Costa, Banaco & Becker 2005; Costa, Banaco, Longarezi, Martins, Maciel & Sudo, 2008; Mace, Mauro, Boyajian & Eckert, 1997; Ward 1976; Weiner, 1969, 1970, 1972).

Weiner (1972) manipulou o reforçador empregado e a forma de apresentá-lo, sobre o comportamento de humanos em FR. Cinco participantes foram expostos a um programa de reforço em FR com três condições de reforço. Na Condição 1 os participantes receberam U$ 0,01 por ponto ganho; na Condição 2 apenas pontos e na Condição 3 receberam U$ 5,39 por sessão e os pontos não eram trocados por dinheiro. Os participantes apresentaram taxas de respostas mais altas e, devido à contingência de razão, ganharam mais pontos nas condições em que os pontos eram trocáveis por dinheiro (Condição 1) do que quando trabalhavam somente por pontos (Condições 2 e 3).

Os resultados de Costa et al. (2008) também sugerem que o reforçador empregado pode afetar o desempenho de humanos em programas de reforço. Estudantes universitários foram distribuídos em dois grupos. Os participantes passaram por duas fases experimentais com diferentes contingências de reforço em cada fase. Para os participantes do Grupo 1, a contingência de reforço de cada fase foi FR - FI (Fases 1 e 2, respectivamente) e para os participantes do Grupo 2 as contingências foram DRL - FI (Fases 1 e 2, respectivamente). Os participantes de cada grupo foram distribuídos em três condições com diferentes conseqüências: pontos trocados por dinheiro; pontos trocados por fotocópias e pontos apenas. Na condição em que pontos eram trocados por dinheiro e na condição em que pontos eram trocados por fotocópias, dinheiro ou créditos em fotocópias eram dados aos participantes ao final de cada sessão. Todos os participantes do Grupo 1 apresentaram taxas altas de respostas durante a exposição ao FR. Quando a contingência mudou para FI, os participantes do Grupo 1 cujos pontos eram trocados por fotocópia ou dinheiro continuaram a apresentar altas taxas de resposta; para os participantes cujos pontos não eram trocados por nada, as taxas de respostas diminuíram com a exposição ao programa de FI. Todos os participantes do Grupo 2 apresentaram baixas taxas de respostas no DRL e, após a mudança da contingência para FI, mantiveram essa taxa baixa, independentemente do reforçador empregado. Esses achados sugerem que o reforçador empregado pode aumentar o efeito de persistência comportamental3 1 Este artigo é derivado da dissertação do primeiro autor, sob orientação do último autor, apresentada em 2007 no programa de mestrado em Análise do Comportamento da Universidade Estadual de Londrina. Rodrigo Cruvinel Salgado foi bolsista CAPES durante o mestrado. Os autores agradecem a colaboração do professor Dr. Marcelo Frota Benvenuti pela leitura cuidadosa da primeira versão deste artigo e suas sugestões. 2 Endereço para correspondência: Universidade Estadual de Londrina - Centro de Ciências Biológicas, Departamento de Psicologia Geral e Análise do Comportamento. Rodovia Celso Garcia Cid, Km 380. Caixa Postal (6001)86051 - 990. Londrina, Paraná. Fone: (43) 3371-4227; (43) 9928-3335. E-mail: caecosta@uel.br após a mudança de uma contingência de FR para FI. Quando as contingências mudam de DRL para FI a probabilidade de um efeito de persistência comportamental é alta, independentemente do reforçador empregado.

Em outro estudo, desta vez com participantes expostos somente a programas de FI, Costa, Banaco e Becker (2005) obtiveram resultados que também sugerem a importância do reforçador empregado em modular os efeitos de programas de reforço sobre o comportamento humano. Universitários foram distribuídos em três condições com diferentes conseqüências (pontos trocados por dinheiro, pontos trocados por fotocópias e pontos apenas). Assim como em Costa et al., (2008), os pontos eram trocados por dinheiro ao final de cada sessão. Na Fase 1 todos os participantes foram expostos a um FI 10 s e na Fase 2 a um de três parâmetros do FI: 5 s, 20 s ou 30 s. Os participantes da condição dinheiro foram aqueles que apresentaram taxas de respostas mais altas na primeira fase. A mudança do parâmetro do FI não alterou substancialmente a taxa de respostas de nenhum dos três participantes da condição dinheiro, de um dos três participantes da condição fotocópias e de dois dos cinco participantes da condição pontos. Os autores sugeriram que pontos trocados por dinheiro pareceram favorecer taxas de respostas altas e constantes em FI. Entretanto, taxas altas e constantes também foram observadas para participantes de outras condições, indicando que a conseqüência experimentalmente programada não é a única variável responsável pelo desempenho em taxas altas em FI.

Contudo, Weiner (1970) apresentou resultados que apontaram para outra direção. Experimentos realizados com humanos sugeriram que a variação no reforçador empregado pouco influenciou o comportamento. Todos os participantes eram expostos à seqüência FR - FI-custo e ganhavam U$ 2,00 por sessão. Para alguns participantes os pontos eram trocados por U$ 0,01 e para outros os pontos não eram trocados por nada. Independentemente do reforçador empregado, 15 dos 16 participantes continuaram a emitir taxas altas de respostas no FI-custo, a despeito de perderem pontos sob esta contingência.

Em resumo, os resultados apresentados de pesquisas com humanos sugerem que o comportamento dos participantes em FI é mais influenciado por uma história de DRL - quer ela seja uma história recente ou remota - do que pela história de FR (Weiner, 1969, 1970). Por outro lado, os resultados de LeFrancois e Metzger (1993) e Cole (2001) indicaram que, para não-humanos (ratos), o desempenho em FI foi mais afetado pela história recente, quer ela tenha sido de FR, quer tenha sido de DRL. Um dos objetivos do presente estudo foi fazer uma replicação sistemática dos estudos de Weiner (1969, 1970) sobre os efeitos da história recente e remota no comportamento atual de humanos em FI.

Uma possível fonte da discrepância dos resultados das pesquisas com humanos e não-humanos apresentados anteriormente pode ser o reforçador empregado. Enquanto Weiner (1969, 1970) pagou os participantes por sessão e a conseqüência que mantinha o comportamento era apenas os pontos obtidos na sessão, LeFrancois e Metzger (1993) e Cole (2001) utilizaram como reforçador pelotas de comida para ratos privados a 80% do seu peso ad lib. Portanto, outro objetivo do presente estudo foi avaliar a influência da utilização de diferentes reforçadores (pontos trocados por dinheiro vs. pontos apenas) sobre os efeitos da história recente e remota no comportamento atual de humanos.

Método

Participantes

Participaram do estudo 12 universitários (cinco homens e sete mulheres). Critérios de exclusão para participação no estudo eram queixar-se ou ter diagnóstico de lesão por esforço repetitivo, que poderia ser agravada pela utilização do mouse, ou ser estudante do curso de Psicologia. Os participantes P1 e P5 conheciam um ao outro, assim como P9 e P12. Apesar de ser solicitado aos participantes que não conversassem com outras pessoas sobre o experimento, nenhum tipo de controle foi realizado a esse respeito.

Equipamentos e Instrumento

O estudo foi conduzido em duas salas experimentais, de aproximadamente 3 m2 cada, divididas por paredes de 2,10 m de altura. Em cada sala experimental havia uma mesa, uma cadeira e um microcomputador com processador Pentium (100MHz ou 133MHz). Ambos os computadores possuíam monitor em cores de 14 polegadas, mouse e teclado padrão. Foram utilizados dois fones de ouvido e dois toca-fitas.

O arranjo de condições experimentais e a coleta de dados foram conduzidos utilizando-se o software ProgRef v3.1 (Costa & Banaco, 2002, 2003). Os participantes deveriam clicar com o cursor do mouse sobre um retângulo visível no centro inferior do monitor (botão de respostas). Pontos eram ganhos de acordo com o programa de reforço arranjado para cada sessão. Quando o participante ganhava algum ponto, uma carinha sorridente estilizada (smile) aparecia no canto superior direito do monitor. Para que o ponto fosse creditado na janela de pontuação (visível no centro superior do monitor, acima do botão de respostas), o participante deveria clicar com o cursor do mouse sobre um botão localizado no canto superior direito da tela (botão de resposta de consumação). Então, o smile desaparecia, um ponto era creditado na janela de pontuação e o participante poderia novamente clicar no botão de respostas.

Caso o participante continuasse a clicar sobre o botão de respostas após o surgimento do smile, estas respostas eram registradas. Entretanto, nenhum smile adicional aparecia até que o participante clicasse no botão de resposta de consumação. Os cronômetros que controlavam a execução do software continuavam em operação durante toda sessão experimental. Portanto, o tempo gasto para movimentar o cursor do botão de respostas até o botão de resposta de consumação e clicá-lo era computado como parte do intervalo entre reforços. O intervalo de um FI ou de um DRL, por exemplo, era iniciado a partir do aparecimento do smile (liberação do "reforço") e não a partir da emissão da resposta de consumação.

Procedimento

As sessões foram realizadas de segunda à sexta-feira, exceto feriados, entre as 8:00 e 20:00 horas, de acordo com a disponibilidade dos participantes e com os horários disponíveis para uso das salas experimentais. Antes da primeira sessão, os participantes liam e assinavam um Termo de Consentimento Livre e Esclarecido (TCLE)4 1 Este artigo é derivado da dissertação do primeiro autor, sob orientação do último autor, apresentada em 2007 no programa de mestrado em Análise do Comportamento da Universidade Estadual de Londrina. Rodrigo Cruvinel Salgado foi bolsista CAPES durante o mestrado. Os autores agradecem a colaboração do professor Dr. Marcelo Frota Benvenuti pela leitura cuidadosa da primeira versão deste artigo e suas sugestões. 2 Endereço para correspondência: Universidade Estadual de Londrina - Centro de Ciências Biológicas, Departamento de Psicologia Geral e Análise do Comportamento. Rodovia Celso Garcia Cid, Km 380. Caixa Postal (6001)86051 - 990. Londrina, Paraná. Fone: (43) 3371-4227; (43) 9928-3335. E-mail: caecosta@uel.br . No TCLE os participantes eram informados se os pontos obtidos na sessão seriam trocados por dinheiro. Caso o participante fosse assinalado a um grupo em que pontos não seriam trocados por dinheiro, tal informação era omitida. Os participantes eram instruídos a deixar do lado externo da sala experimental todo o seu material, relógio e telefone celular e, para fins de isolamento acústico, os participantes utilizaram fones de ouvido durante as sessões por meio do qual era transmitido um ruído branco. O participante lia as seguintes instruções em uma folha:

Obrigado por sua colaboração! Sua tarefa será clicar com o botão esquerdo do mouse sobre um retângulo que aparece na parte inferior do monitor para obter pontos. Abaixo você pode observar o layout da tela. [Uma figura com o desenho da tela era apresentada]. Você deve tentar ganhar o maior número de pontos que você conseguir. Você ganhará pontos clicando sobre o botão de uma maneira específica. Os pontos aparecerão na janela que se localiza na parte superior da tela na posição central. Entretanto, quando você ganhar algum ponto aparecerá no canto superior direito do monitor um smile. Você deverá, então, clicar com a seta do mouse sobre o botão que se localiza no canto superior direito da tela. Ao fazer isso o smile desaparecerá e o ponto será creditado no contador. Quando um smile aparecer no monitor não aparecerá outro até que você clique no botão menor no canto superior direito. Depois que o smile desaparece - e o ponto é creditado - você pode voltar a clicar sobre o botão maior na parte inferior do monitor para ganhar mais pontos. Boa sorte!

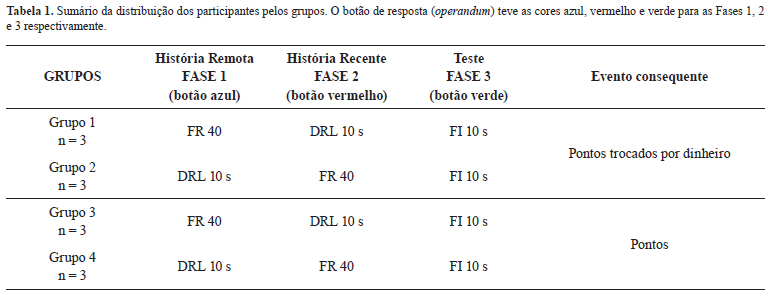

Os participantes foram distribuídos em quatro grupos de três participantes cada, conforme descrito na Tabela 1. Para os participantes do Grupo 1-Dinheiro e do Grupo 2-Dinheiro os pontos obtidos durante cada sessão experimental eram trocados por dinheiro (R$ 0,05 por ponto). Os participantes do Grupo 3-Pontos e do Grupo 4-Pontos recebiam apenas os pontos. A cor do botão de respostas foi alterada entre as diferentes fases do estudo (uma característica semelhante aos estudos de Weiner, 1969, 1970 e de Costa et al., 2008). O estudo consistiu das seguintes fases experimentais:

Fase 1 - construção da história remota: Os participantes dos Grupos 1 e 3 eram expostos a um FR 40. Sob este programa de reforço eles deveriam pressionar o botão de respostas com o cursor do mouse por 40 vezes para que o smile aparecesse, a resposta de consumação pudesse ser emitida e um ponto fosse creditado no contador. Os participantes dos Grupos 2 e 4 eram expostos a um DRL 10 s. Neste programa de reforço o participante deveria emitir uma resposta após, pelo menos, 10 segundos decorridos desde a amitlú resposta. Se uma resposta fosse emitida antes de transcorridos os 10 segundos, o cronômetro era zerado e um novo intervalo era iniciado. Nesta fase, a cor do botão de respostas era azul. Foram planejadas seis sessões experimentais de 15 minutos cada para o término da Fase 1 e o início da Fase 2.

Treino em DRL: Quando algum participante exposto ao DRL apresentava taxas de respostas altas o suficiente para não ganhar nenhum ponto (ou ganhar muito menos do que a quantidade de pontos disponíveis na sessão) era realizado um treino em DRL. As sessões de treino tiveram duração de 15 minutos e consistiram em expor o participante a um DRL no qual o intervalo entre respostas exigido era aumentado a cada 10 pontos. A seqüência de exposição consistia em um DRL 2, 4, 6, 8 e 10 segundos. O incremento dos intervalos era feito automaticamente pelo software, sem que o experimentador precisasse interromper as sessões. Caso a sessão acabasse antes que um DRL 10 s tivesse sido atingido, o treino continuava na sessão seguinte e o parâmetro inicial do DRL era o amitvú parâmetro sob o qual o participante havia obtido 10 pontos. Por exemplo, se a sessão terminasse quando o participante havia ganhado três pontos sob o DRL 8 s, a sessão seguinte começaria com um DRL 6 s. Quando sessões de treino em DRL eram requeridas, o número total de sessões realizadas nesta fase foi maior que o originalmente proposto (seis sessões). Para P8 e P10, participantes expostos ao treino em DRL, o número de sessões em fases subseqüentes ao DRL foi menor que o originalmente proposto (seis sessões)5 1 Este artigo é derivado da dissertação do primeiro autor, sob orientação do último autor, apresentada em 2007 no programa de mestrado em Análise do Comportamento da Universidade Estadual de Londrina. Rodrigo Cruvinel Salgado foi bolsista CAPES durante o mestrado. Os autores agradecem a colaboração do professor Dr. Marcelo Frota Benvenuti pela leitura cuidadosa da primeira versão deste artigo e suas sugestões. 2 Endereço para correspondência: Universidade Estadual de Londrina - Centro de Ciências Biológicas, Departamento de Psicologia Geral e Análise do Comportamento. Rodovia Celso Garcia Cid, Km 380. Caixa Postal (6001)86051 - 990. Londrina, Paraná. Fone: (43) 3371-4227; (43) 9928-3335. E-mail: caecosta@uel.br .

Fase 2 - construção da história recente: Os participantes dos Grupos 1 e 3, expostos anteriormente ao FR 40, eram expostos ao DRL 10 s e os participantes dos Grupos 2 e 4, expostos anteriormente ao DRL 10 s, eram expostos ao FR 40. Nesta fase, a cor do botão de respostas era vermelha. Foram planejadas seis sessões experimentais de 15 minutos cada para o término da Fase 2 e o início da Fase 3. Quando algum participante exposto ao DRL apresentava taxas de respostas altas o suficiente para não ganhar nenhum ponto (ou ganhar muito menos do que a quantidade de pontos disponíveis na sessão) era realizado o treino em DRL descrito anteriormente.

Fase 3 - teste: Todos os participantes eram expostos a um FI 10 s. Para ganhar pontos sob esta contingência de reforço, o participante deveria emitir uma resposta após, pelo menos, 10 segundos decorridos desde o aparecimento do último smile. Respostas que ocorressem antes do intervalo especificado não tinham conseqüências experimentais programadas. Nesta fase, a cor do botão de respostas era verde. Foram planejadas seis sessões experimentais de 15 minutos cada para o término da Fase 3.

Resultados

Os resultados foram agrupados de modo a destacar a influência dos diferentes reforçadores empregados (pontos trocados por dinheiro vs. pontos apenas) sobre os efeitos de histórias recente e remota no comportamento dos participantes quando expostos ao FI. Primeiramente serão apresentados os resultados dos participantes do Grupo 1-Dinheiro e do Grupo 3-Pontos (ver Tabela 1), expostos à seqüência FR - DRL - FI. Em seguida serão apresentados os resultados dos participantes do Grupo 2-Dinheiro e do Grupo 4-Pontos (ver Tabela 1), expostos à seqüência DRL - FR - FI.

Resultados dos participantes do Grupo 1-Dinheiro e do Grupo 3-Pontos com história remota de FR e história recente de DRL.

A Figura 1 exibe a taxa de respostas (R/min) de pressão ao botão por sessão, dos participantes do Grupo 1-Dinheiro e do Grupo 3-Pontos, em cada uma das três fases do estudo. Sessões de treino em DRL são indicadas na Figura 1 por asteriscos.

Taxas de respostas relativamente altas (acima de 125 R/min) foram observadas para todos os participantes, de ambos os grupos, durante exposição ao FR, com exceção de P3 que apresentou taxas relativamente mais baixas (mas superiores a 62 R/min). Exceto pelo desempenho desse participante, a conseqüência empregada para cada um dos grupos aparentemente não afetou diferencialmente a taxa de respostas emitidas pelos participantes em FR.

Quando o programa de reforço mudou de FR 40 para DRL 10 s, observou-se uma diminuição na taxa de respostas de dois dos três participantes do Grupo 1-Dinheiro (P1 e P2) e um dos três participantes do Grupo 3-Pontos (P9) com a exposição continuada a este programa de reforço. Os outros participantes (P3, do Grupo 1 e P7 e P8, do Grupo 3) passaram por sessões de treino em DRL. Nas três sessões finais de exposição ao DRL, todos os participantes, de ambos os grupos, apresentaram taxas baixas de respostas (abaixo de 12 R/min), com exceção de P7 que emitiu 40, 32 e 13 R/min nas três sessões finais de DRL. Com a mudança no programa de reforço para FI 10 s, as taxas de respostas foram baixas para a maior parte dos participantes dos Grupos 1 e 3 (abaixo de 13 R/mim), exceto para P2 e P8, cujas taxas de respostas variaram de 6 a 156 R/min (P2) e de 29 a 139 R/min (P8).

A Figura 2 exibe os registros cumulativos de cada participante do Grupo 1-Dinheiro e do Grupo 3-Pontos. São exibidas a última sessão em FR, a última sessão em DRL e a primeira e a última sessão em FI.

Como se observa na Figura 2, a taxa de respostas de todos os participantes é relativamente alta e constante na última sessão de FR. Todos os participantes, exceto P3, apresentaram taxas de respostas superiores a 240 R/min nesta sessão (P3 apresentou taxa de respostas relativamente mais baixa, cerca de 70 R/min). Nota-se também que todos os participantes apresentaram taxas de respostas relativamente mais baixas na última sessão de DRL. Com exceção de P7 (que foi exposto ao treino em DRL), os participantes emitiram taxas inferiores a 7 R/min na última sessão de exposição a esse programa de reforço. Mesmo após o treino em DRL, apesar da taxa de respostas permanecer baixa na maior parte da sessão, este participante sempre iniciava as sessões de DRL emitindo altas taxas de respostas. A taxa de respostas geral na última sessão de DRL de P7 foi de 13 R/min. Entretanto, a taxa local de respostas, nos últimos 5 minutos da sessão foi de 4,8 R/min (i.e., uma taxa de resposta equivalente à dos demais participantes nas sessões finais de DRL). Tomados em conjunto, estes resultados sugerem que o comportamento dos participantes ficou sob controle das contingências programadas nas Fases 1 e 2 do estudo, quer fosse empregado dinheiro quer fosse empregado apenas pontos como eventos conseqüentes às respostas.

Quando o programa de reforço mudou de DRL 10 s para FI 10 s, observa-se, na Figura 2, taxa baixa de respostas para P1 e P3 e um padrão que variou entre taxa baixa e relativamente alta para P2. As taxas de respostas em FI de P1 foram ligeiramente maiores que as observadas em DRL (5 R/min na última sessão de DRL e 11 R/min na última sessão de FI) e ligeiramente maiores do que aquelas observadas para P3 durante a exposição ao FI. Esse resultado sugere que o comportamento P1 em FI estava sob controle da contingência presente e não tanto sob controle da história de DRL, pois um aumento na taxa de respostas sem prejuízo do número de pontos obtidos na sessão só é possível em um programa de FI. O desempenho de P3 sob FI assemelha-se ao de P1, porém ocorre em taxas mais baixas e indica possíveis efeitos da história recente de DRL (4,6 R/min na última sessão de DRL e 5,4 R/min na última sessão de FI). P2 exibiu um misto de taxas altas e baixas em praticamente todas as sessões de FI. O padrão comportamental deste participante em FI assemelha-se ora ao padrão observado durante o FR, ora ao padrão observado durante o DRL (não há um padrão "intermediário" de respostas). Isto sugere uma influência tanto da história recente (DRL) quanto da história remota (FR) sobre o comportamento deste participante durante a exposição ao FI.

O desempenho de P7 durante a exposição ao FI, apesar de ser predominantemente em taxas baixas, alternou entre alta e baixa taxa de respostas. Isto sugere que o comportamento deste participante foi influenciado por ambos os programas de reforço aos quais foi anteriormente exposto. Esse padrão comportamental foi observado durante a exposição desse participante ao DRL e persistiu durante a exposição ao FI (com a diferença que no DRL taxas altas de respostas apareciam, comumente, apenas no início da sessão). Com a exposição continuada ao FI, as taxas altas de respostas diminuíram progressivamente, como pode ser observado no registro cumulativo da última sessão de exposição a esse programa de reforço.

Resultados similares foram obtidos para P8. Quando exposto ao FI, o desempenho desse participante foi um misto de taxa baixa e alta, o que sugere efeitos de histórias recente e remota, mas, diferentemente dos demais participantes, a taxa de respostas aumentou progressivamente até a última sessão de FI (6 R/min na última sessão de DRL e 52 R/min na última de FI). P9 respondeu de modo relativamente constante em FI, com um padrão semelhante àquele observado quando de sua exposição ao DRL, embora com taxas de respostas relativamente mais altas. Na última sessão de DRL, a taxa geral de respostas de P9 foi de 5 R/min; quando o programa de reforco mudou para FI, a taxa foi de 5 R/min na primeira sessão e de 13 R/min na última sessão. Esse aumento na taxa de respostas parece indicar que, embora a história de exposição ao DRL exercesse algum efeito, o comportamento desse participante estava também sob controle da contingência presente de FI.

Em geral, não houve diferenças sistemáticas entre o desempenho dos participantes dos Grupos 1 e 3. Nos dois casos houve alguma variabilidade no comportamento entre sessões sob FI (ver Figuras 1 e 2), que sugere ou uma possível influência tanto da história de FR quanto da de DRL (e.g., P2 e) ou uma influência mais acentuada da história recente de DRL (P1 e P3; P7 e P9). Em adição, observou-se que a contingência de FI exerceu efeitos de maneira mais clara no desempenho de dois participantes (P1 e P9).

Resultados dos participantes dos Grupos 2-Dinheiro e do Grupo 4-Pontos com história remota de DRL e história recente de FR.

A Figura 3 exibe a taxa de respostas (R/min) por sessão, dos participantes dos Grupos 2 e 4, em cada uma das três condições experimentais. Pode-se observar que a taxa de respostas da maioria dos participantes diminuiu com a exposição continuada ao DRL e foi relativamente baixa nas sessões finais dessa fase (com exceção de P10, que precisou de duas sessões de treino em DRL após a sexta sessão). Nas três sessões finais da exposição ao DRL, as taxas de respostas de todos os participantes foi inferior a 6 R/min. Quando a contingência mudou de DRL 10 s para FR 40 - e com a exposição continuada a este programa de reforço - todos os participantes emitiram taxas altas de respostas (acima de 117 R/min nas três últimas sessões de FR).

Quando a condição experimental mudou para FI 10 s, a taxa de respostas de todos os participantes diminuiu em relação àquela observada nas últimas sessões de exposição ao FR. Entretanto, observa-se que as taxas de respostas dos participantes do Grupo 4-Pontos foram, em geral, mais baixas do que aquelas dos participantes do Grupo 2-Dinheiro.

Na Figura 4 são apresentados os registros cumulativos das respostas de pressão ao botão dos participantes do Grupo 2 e Grupo 4, da última sessão de exposição ao DRL 10 s, da última sessão de exposição ao FR 40, e da primeira e da última sessão de exposição FI 10 s.

Para todos os participantes do Grupo 2-Dinheiro e do Grupo 4-Pontos, o desempenho na última sessão de DRL foi de taxas baixas (inferiores a 6 R/min) e o desempenho final em FR foi de taxas relativamente altas e constantes (superiores a 147 R/min). Durante a primeira e a última sessões de exposição ao FI, observou-se uma maior variabilidade na taxa de respostas intra e entre participantes no Grupo 2.

P4 apresentou, alternadamente, taxas de respostas altas e baixas. Na última sessão sob FI, um padrão de taxa baixa de respostas tornou-se preponderante, o que sugere controle pelo programa de reforço vigente. P5, sob FI, apresentou taxa de respostas relativamente mais baixas do que emitiu na última sessão sob FR, porém ainda consideravelmente superiores àquelas emitidas sob DRL. Nos últimos seis minutos de exposição ao FI, P5 apresentou taxa de respostas relativamente baixa. Embora a taxa geral de respostas tenha diminuído com a exposição continuada ao FI para esse participante (ver Figura 3), o padrão comportamental observado foi de taxa de respostas moderadas e constantes - com valores entre aqueles obtidos em DRL e em FR. O desempenho de P6 sob FI foi um misto de taxas de respostas alta e baixa na primeira sessão. Entretanto, diferentemente de P4 e P5, a taxa de respostas não diminuiu com a exposição continuada ao FI para esse participante e, na última sessão de FI, a taxa de respostas apresentou valores similares aqueles obtidos nas últimas sessões de exposição ao FR.

De maneira geral, o comportamento dos participantes do Grupo 2 parece ter sido influenciado tanto pela história recente de FR quanto pela história remota de DRL - sem prejuízo de um possível controle pela contingência presente de FI. Entretanto, o efeito da história recente de FR parece ter sido preponderante, sobretudo quando se comparam os desempenhos em FI desses participantes com o desempenho dos participantes do Grupo 1. Os resultados, dos participantes dos Grupos 1 e 2 (que receberam pontos trocados por dinheiro), sugerem um efeito predominante da história recente (quer ela fosse de DRL, quer ela fosse de FR) sobre o desempenho em FI. No caso dos desempenhos dos participantes dos Grupos 3 e 4 (que receberam pontos apenas), o efeito de história predominante parece ter sido de DRL (quer esta contingência fosse parte da história remota, quer ela fosse parte da história recente dos participantes). Adicionalmente, a análise visual dos registros cumulativos de todos os participantes (dos quatro grupos), sugere que, com a exposição continuada ao programa de FI, o comportamento dos participantes ficou sob controle da contingência de reforço vigente. Isso, contudo, ocorreu mais acentuadamente em alguns casos do que outros.

Discussão

Os resultados deste estudo sugerem que o reforçador empregado pode modular os efeitos da história comportamental sobre o comportamento de humanos em FI. De maneira geral, quando a conseqüência programada foi "pontos trocados por dinheiro" (Grupos 1 e 2), a taxa de respostas em FI foi, aparentemente, mais afetada pela história recente, quer esta tenha sido de FR ou DRL (embora os registros cumulativos indiquem que a taxa de respostas intra-sessões, em alguns casos, tenha sido um misto de altas e baixas taxas de respostas, o que sugere que tanto a história de FR quanto a de DRL afetaram o modo como o participante respondeu em FI). Esses resultados foram semelhantes àqueles obtidos em pesquisas com ratos, nos quais a taxa de respostas observadas em FI parecia ser mais influenciada pela história recente do que pela história remota (Cole, 2001; LeFrancois & Metzger, 1993). Quando a conseqüência programada foi "pontos apenas" (Grupos 3 e 4), a taxa de respostas em FI assemelhou-se mais àquela observada durante a exposição ao DRL, quer a história de DRL tenha sido remota ou recente (embora tenha sido também observado uma alternação entre altas e baixas taxas de respostas para alguns participantes desses grupos, e.g., P8 do Grupo 3 e P12 do Grupo 4). Esses resultados assemelham-se àqueles obtidos com humanos nos quais uma história de DRL, quer fosse parte de uma história recente ou remota, aumentou a probabilidade de um desempenho em baixas taxas sob um FI subseqüente (e.g., Weiner, 1969, 1970).

A baixa taxa de respostas na última sessão em FI de P1, P4, P9, P10 e P12 sugere que o comportamento desses participantes foi influenciado também pela contingência presente de FI e não apenas pela história de DRL, uma vez que a taxa de respostas na última sessão de FI aumentou em relação à última sessão de DRL. Um aumento na taxa de respostas em FI após uma história de DRL também foi observado nos estudos de Costa et al. (2008); Freeman e Lattal (1992); LeFrancois e Metzger (1993); Weiner (1964, 1969) e Urbain, Poling, Millam e Thompson (1978). Os resultados do presente estudo vão na mesma direção dos estudos que sugerem que o reforçador empregado é uma variável importante a ser considerada (e.g., Costa et al., 2008; Mace et al., 1997; Ward, 1976; Weatherly, Stout, Davis & Melville, 2001; Weiner, 1972) sobretudo quando a comparação do desempenho de humanos e não-humanos em programas de reforço é uma questão central.

Todavia, os resultados do presente estudo não corroboram os de Weiner (1970), no que diz respeito a influência do reforçador empregado em modular os efeitos da história. Naquele estudo, as diferentes conseqüências programadas para o comportamento de humanos (pontos ou pontos trocados por dinheiro) não afetaram o desempenho em FI-custo, após uma história de exposição ao FR. No entanto, os participantes do estudo de Weiner foram pagos por sessão, independente do desempenho. Diferentemente, no presente estudo, o pagamento dos participantes (Grupo 1 e Grupo 3) se deu de forma contingente ao desempenho. Este fator do procedimento no estudo de Weiner (i.e., o pagamento por sessão independente do desempenho) pode ter diminuído o valor reforçador de pontos trocados por dinheiro em comparação à condição em que em que participantes recebiam pontos apenas, o que poderia explicar a discrepância entre os resultados obtidos naquele estudo em relação aos obtidos no presente estudo.

Esta interpretação não é coerente com aquelas oferecidas por estudos sobre momento comportamental, segundo as quais uma redução no valor do reforçador comumente produz uma menor resistência à mudança (Santos, 2005). Os resultados de Weiner (1970) apontam para maior resistência à mudança (ou maior persistência comportamental - os participantes continuaram a emitir altas taxas de respostas sob FI-custo após uma história de FR). Replicações diretas ou sistemáticas poderiam avaliar a generalidade dos dados de Weiner e avaliar o forte efeito de persistência comportamental obtido naquele estudo.

Resultados de estudos com não-humanos sugeriram que a taxa de respostas em FR tende a ser mais baixa quando um programa em DRL precede uma condição em FR (Cole, 2001; Wanchisen, Sutphin, Balogh & Tatham, 1998). Os participantes submetidos à seqüência DRL - FR - FI (Grupos 2 e 4) emitiram, sob FR, taxas de respostas equivalentes a dos participantes submetidos à seqüência FR - DRL - FI (Grupos 1 e 3). Esses resultados indicam que a taxa de respostas dos participantes do presente estudo, quando expostos a FR não foi influenciada sistematicamente pela presença ou ausência de uma história de DRL. Efeitos de uma história de DRL foram observados apenas na primeira sessão de exposição ao FR (ver Figura 3).

Alguns aspectos do método do presente estudo merecem consideração, uma vez que podem esclarecer os limites e a generalidade dos dados obtidos. Não foram identificadas diferenças entre o desempenho dos participantes expostos ou não ao treino em DRL no comportamento subseqüente em FI (ver, comparativamente, os resultados de P1 e P11, não expostos ao treino, e P3 e P10, expostos ao treino). Contudo, a adoção de um treino em DRL poderia ser controlada em estudos futuros, por exemplo, submetendo-se todos os participantes ao procedimento de treino. Poderia ser programado um aumento gradativo nos parâmetros do DRL (e.g., 2 s, 4 s, 6 s, em uma primeira sessão, e 6 s, 8 s e 10 s, em uma segunda sessão de treino). Um arranjo experimental como esse, muito provavelmente, selecionaria um padrão de baixas taxas de respostas para todos os participantes. Aumento gradual nos parâmetros do DRL foi adotado nos estudos de Cole (2001) e LeFrancois e Metzger (1993). Além disso, este critério tornaria mais semelhantes as condições experimentais entre os estudos com humanos e não-humanos. Outra opção seria não adotar o treino, expondo os participantes ao parâmetro final do DRL até a obtenção de um padrão estável na taxa de respostas. Neste caso, a logística e o número de sessões devem ser revistos, para que sejam adequados às necessidades dos participantes e do próprio estudo (ver, por exemplo, o arranjo das sessões experimentais em termos de número e duração utilizadas por Okouchi, 2007).

O número relativamente reduzido de participantes em cada um dos grupos também deve ser levado em consideração. Apesar dos efeitos de histórias recentes e remotas terem sido avaliados utilizando o participante como seu próprio controle, parte da análise foi feita comparando-se o desempenho dos participantes de cada grupo. Os resultados mostraram alguma variabilidade no desempenho dos participantes, intra e intergrupos. Okouchi (2002) sugeriu que uma das razões para as inconsistências nos resultados das pesquisas com humanos expostos a FI poderia ser o número de participantes empregados em cada estudo (comumente, menos de 10 participantes). Em delineamentos de caso único, cada sujeito é uma tentativa de replicação dos resultados (Sidman, 1960) e, portanto, um maior número de participantes em cada grupo talvez contribuísse para maior generalidade dos resultados intragrupos.

Com relação à manipulação de estímulos correlacionados aos programas de reforço nas diferentes fases do estudo, nota - se que nos procedimentos de Cole (2001) e de LeFrancois e Metzger (1993) com ratos, não houve qualquer mudança de estímulos programada concomitante à mudança nos programas de reforço. Este procedimento pode ter contribuído para que o comportamento durante a fase de teste fosse mais semelhante ao padrão selecionado durante a fase de construção da história recente. Ao contrário, no estudo de Weiner (1969; 1970), assim como no presente estudo, ocorreram mudanças de estímulos entre as fases experimentais. Essa mudança de estímulos pode ter aumentado a probabilidade de mudança na taxa de respostas em FI, pois os participantes haviam passado por uma situação em que a mudança na cor do botão de respostas foi correlacionada a uma mudança nos critérios da taxa de respostas (diferentes programas de reforço) necessária para a obtenção de pontos. Freeman e Lattal (1992) e Okouchi (2003a; 2003b) sugeriram que o controle de estímulos é uma variável importante quando se consideram os efeitos da história sobre o comportamento atual de humanos e não-humanos. Poderia ser interessante realizar uma replicação sistemática do presente estudo na qual a cor do botão de respostas não variasse entre as fases do procedimento. No estudo de Okouchi (2007) não houve qualquer mudança de estímulos programada concomitante à mudança nos programas de reforço, entretanto, o intervalo entre reforços (IRI) pareceu ter função discriminativa sobre o desempenho subsequente dos participantes. Naquele estudo, os efeitos da história remota foram mais prováveis quando o IRI arranjado pelo programa de reforço presente foi mais longo que aquele arranjado ou obtido durante a fase de história recente. Portanto, em estudos futuros, é aconselhável controlar também o IRI entre as diferentes fases do estudo.

Os resultados e as considerações aqui apresentados são diferentes daquelas apresentadas por Weiner (1969, 1970), pois sugerem que uma história de DRL não garante um desempenho de humanos em taxas baixas de respostas sob FI subseqüente. O reforçador empregado parece ser um importante fator do procedimento (Costa et al., 2005; Costa et al., 2008; Mace et al., 1997; Ward, 1976; Weiner, 1972) e sugerem-se avaliações adicionais de seus efeitos. A interação entre as contingências presentes e as contingências da história remota e recente parece ser outra variável que influencia a probabilidade de efeitos de história remota em humanos (Okouchi, 2007). Além disso, os resultados do presente estudo sugerem que o comportamento presente é influenciado tanto pela história recente quanto pela história remota e que o reforçador empregado pode ser uma variável a modular esse efeito. Uma tarefa que se coloca para os pesquisadores é o estudo das condições necessárias e suficientes para a ocorrência ou não de tais interações.

Referências

Baum, W. M. (2006). Compreender o Behaviorismo: comportamento, cultura e evolução (M. T. A. Silva, M. A. Matos, G. Y. Tomanari, E. Z. Tourinho & F. Dentello, Trad.) (2ª ed.). Porto Alegre: Artes Médicas.

Chiesa, M. (1994) Radical behaviorism: The philosophy and the science. Boston: Authors Cooperative, Inc., Publishers.

Cole, M. R. (2001) The long term effect of high and low rate responding histories on fixed-interval responding in rats. Journal of the Experimental Analysis of Behavior, 75, 43-54.

Costa, C. E., & Banaco, R.A. (2002). ProgRef v3: sistema computadorizado para a coleta de dados sobre programas de reforço com humanos - recursos básicos. Revista Brasileira de Terapia Comportamental e Cognitiva, 4(2), 171-172.

Costa, C. E., & Banaco, R.A. (2003). ProgRef v3: sistema computadorizado para a coleta de dados sobre esquemas de reforço com humanos - recursos adicionais. Revista Brasileira de Terapia Comportamental e Cognitiva, 5(2), 219-229.

Costa, C. E., Banaco, R. A., & Becker, R. M. (2005). Desempenho em FI com humanos: Efeito do tipo de reforçador. Temas em Psicologia, 13(1), 18-33.

Costa, C. E., Banaco, R. A., Longarezi, D. M., Martins, E. V., Maciel, E. M., & Sudo, C. H. (2008). O tipo de reforçador como uma variável moduladora dos efeitos da história em humanos. Psicologia: Teoria e Pesquisa, 24(2), 251-262.

Costa, C. E., Cirino, S. D., Cançado, C. R. X., & Soares, P. G. S. (2009). Polêmicas sobre história comportamental: Identificação de seus efeitos e sua duração. Psicologia: Reflexão e Crítica, 22(3), 394-403.

Ferster, C. B., & Skinner, B. F. (1957). Schedules of reinforcement. New York: Appleton.

Freeman, T. J., & Lattal, K. A. (1992). Stimulus control of behavior history. Journal of Experimental Analysis of Behavior, 57, 5-15. LeFrancois, J. R., & Metzger, B. (1993). Low-response-rate conditioning history and fixed-interval responding in rats. Journal of the Experimental Analysis of Behavior, 59(3), 543-549.

Mace, F. C., Mauro, B. C., Boyajian, A. E., & Eckert, T. L. (1997) Effects of reinforcer quality on behavioral momentum: Coordinate applied and basic research. Journal of Applied Behavior Analysis, 30(1), 1-20.

Okouchi, H. (2002). Individual differences in human fixed-interval performance. Psychological Record, 52, 173-186.

Okouchi, H. (2003a). Effects of differences in interreinforcer intervals between past and current schedules on fixed-interval responding. Journal of the Experimental Analysis of Behavior, 79(1), 49-64.

Okouchi, H. (2003b). Stimulus generalization of behavioral history. Journal of the Experimental Analysis of Behavior, 80(2), 173-186. Okouchi, H. (2007). An exploration of remote history effects in humans. Psychological Record, 57, 241-263.

Ono, K., & Iwabuchi, K. (1997). Effects of histories of differential reinforcement of response rate on variable-interval responding. Journal of the Experimental Analysis of Behavior, 67(3), 311-322.

Perone, M., Galizio, M., & Baron, A. (1988). The relevance of animal-based principles in the laboratory study of human operant conditioning. Em G. Davey & C. Cullen (Eds.). Human operant conditioning and behavior modification (pp. 59-84). Chichester, England: John Wiley & Sons Ltd.

Santos, C. V. (2005). Momento Comportamental. Em J. Abreu-Rodrigues & M. R. Ribeiro (Eds.). Análise do Comportamento: Pesquisa, teoria e aplicação (pp. 63-80). Porto Alegre: Artmed.

Sidman, M. (1960). Tactics of scientific research. New York: Basic Books.

Skinner, B. F. (1993). Ciência e comportamento humano (J. C. Todorov & R. Azzi, Trad.). São Paulo: Martins Fontes (Trabalho original publicado em 1953).

Skinner, B. F. (1974). About behaviorism. New York: Knopf.

Skinner, B. F. (1981). Selection by consequences. Science, 213, 501-504.

Urbain, C., Poling, A., Millam, J., & Thompson, T. (1978). d-Amphetmine and fixed-interval performance: effects of operant history. Journal of the Experimental Analysis of Behavior, 29(3), 385-392.

Wanchisen, B. A. (1990). Forgetting the lessons of history. The Behavior Analyst, 13, 31-37.

Wanchisen, B., Sutphin, G. E., Balogh, S. A., & Tatham, T. A. (1998). Lasting effects of a behavioral history of low-rate responding in rats. Learning and Motivation, 29, 220-235.

Wanchisen, B., & Tatham, T. A. (1991). Behavioral history: A promising challenge in explaining and controlling human operant behavior. The Behavior Analyst, 14(2), 139-144.

Ward, J. (1976). Variation of reinforcement in performance of a motor skill. Perceptual and Motor Skills, 43, 149-150.

Weatherly, J. N., Stout, J. E., Davis, C. S., & Melville, C. L. (2001). For better or worse: Effect of upcoming reinforcer type on rats' lever pressing for low-concentration sucrose reinforcers. The Psychological Record, 51, 629-644.

Weiner, H. (1964). Conditioning history and human fixed-interval performance. Journal of the Experimental Analysis of Behavior, 7, 383-385.

Weiner, H. (1969). Controlling human fixed-interval performance. Journal of the Experimental Analysis of Behavior, 12, 349-373. Weiner, H. (1970). Human behavioral persistence. The Psychological Record, 20, 445-456.

Weiner, H. (1972). Human fixed-ratio responding as a function of the type of reinforcer (money vs. points) and the presence or absence of a noncontingent monetary wage. The Psychological Record, 21, 497-500.

Recebido em 24.04.2009

Primeira decisão editorial em 08.01.2010

Versão final em 18.01.2010

Aceito em 25.02.2010

- Baum, W. M. (2006). Compreender o Behaviorismo: comportamento, cultura e evolução (M. T. A. Silva, M. A. Matos, G. Y. Tomanari, E. Z. Tourinho & F. Dentello, Trad.) (2Ş ed.). Porto Alegre: Artes Médicas.

- Chiesa, M. (1994) Radical behaviorism: The philosophy and the science. Boston: Authors Cooperative, Inc., Publishers.

- Cole, M. R. (2001) The long term effect of high and low rate responding histories on fixed-interval responding in rats. Journal of the Experimental Analysis of Behavior, 75, 43-54.

- Costa, C. E., & Banaco, R.A. (2002). ProgRef v3: sistema computadorizado para a coleta de dados sobre programas de reforço com humanos - recursos básicos. Revista Brasileira de Terapia Comportamental e Cognitiva, 4(2), 171-172.

- Costa, C. E., & Banaco, R.A. (2003). ProgRef v3: sistema computadorizado para a coleta de dados sobre esquemas de reforço com humanos - recursos adicionais. Revista Brasileira de Terapia Comportamental e Cognitiva, 5(2), 219-229.

- Costa, C. E., Banaco, R. A., & Becker, R. M. (2005). Desempenho em FI com humanos: Efeito do tipo de reforçador. Temas em Psicologia, 13(1), 18-33.

- Costa, C. E., Banaco, R. A., Longarezi, D. M., Martins, E. V., Maciel, E. M., & Sudo, C. H. (2008). O tipo de reforçador como uma variável moduladora dos efeitos da história em humanos. Psicologia: Teoria e Pesquisa, 24(2), 251-262.

- Costa, C. E., Cirino, S. D., Cançado, C. R. X., & Soares, P. G. S. (2009). Polêmicas sobre história comportamental: Identificação de seus efeitos e sua duração. Psicologia: Reflexão e Crítica, 22(3), 394-403.

- Ferster, C. B., & Skinner, B. F. (1957). Schedules of reinforcement New York: Appleton.

- Freeman, T. J., & Lattal, K. A. (1992). Stimulus control of behavior history. Journal of Experimental Analysis of Behavior, 57, 5-15.

- LeFrancois, J. R., & Metzger, B. (1993). Low-response-rate conditioning history and fixed-interval responding in rats. Journal of the Experimental Analysis of Behavior, 59(3), 543-549.

- Mace, F. C., Mauro, B. C., Boyajian, A. E., & Eckert, T. L. (1997) Effects of reinforcer quality on behavioral momentum: Coordinate applied and basic research. Journal of Applied Behavior Analysis, 30(1), 1-20.

- Okouchi, H. (2002). Individual differences in human fixed-interval performance. Psychological Record, 52, 173-186.

- Okouchi, H. (2003a). Effects of differences in interreinforcer intervals between past and current schedules on fixed-interval responding. Journal of the Experimental Analysis of Behavior, 79(1), 49-64.

- Okouchi, H. (2003b). Stimulus generalization of behavioral history. Journal of the Experimental Analysis of Behavior, 80(2), 173-186.

- Okouchi, H. (2007). An exploration of remote history effects in humans. Psychological Record, 57, 241-263.

- Ono, K., & Iwabuchi, K. (1997). Effects of histories of differential reinforcement of response rate on variable-interval responding. Journal of the Experimental Analysis of Behavior, 67(3), 311-322.

- Perone, M., Galizio, M., & Baron, A. (1988). The relevance of animal-based principles in the laboratory study of human operant conditioning. Em G. Davey & C. Cullen (Eds.). Human operant conditioning and behavior modification (pp. 59-84). Chichester, England: John Wiley & Sons Ltd.

- Santos, C. V. (2005). Momento Comportamental. Em J. Abreu-Rodrigues & M. R. Ribeiro (Eds.). Análise do Comportamento: Pesquisa, teoria e aplicação (pp. 63-80). Porto Alegre: Artmed.

- Sidman, M. (1960). Tactics of scientific research New York: Basic Books.

- Skinner, B. F. (1993). Ciência e comportamento humano (J. C. Todorov & R. Azzi, Trad.). São Paulo: Martins Fontes (Trabalho original publicado em 1953).

- Skinner, B. F. (1974). About behaviorism New York: Knopf.

- Skinner, B. F. (1981). Selection by consequences. Science, 213, 501-504.

- Urbain, C., Poling, A., Millam, J., & Thompson, T. (1978). d-Amphetmine and fixed-interval performance: effects of operant history. Journal of the Experimental Analysis of Behavior, 29(3), 385-392.

- Wanchisen, B. A. (1990). Forgetting the lessons of history. The Behavior Analyst, 13, 31-37.

- Wanchisen, B., Sutphin, G. E., Balogh, S. A., & Tatham, T. A. (1998). Lasting effects of a behavioral history of low-rate responding in rats. Learning and Motivation, 29, 220-235.

- Wanchisen, B., & Tatham, T. A. (1991). Behavioral history: A promising challenge in explaining and controlling human operant behavior. The Behavior Analyst, 14(2), 139-144.

- Ward, J. (1976). Variation of reinforcement in performance of a motor skill. Perceptual and Motor Skills, 43, 149-150.

- Weatherly, J. N., Stout, J. E., Davis, C. S., & Melville, C. L. (2001). For better or worse: Effect of upcoming reinforcer type on rats' lever pressing for low-concentration sucrose reinforcers. The Psychological Record, 51, 629-644.

- Weiner, H. (1964). Conditioning history and human fixed-interval performance. Journal of the Experimental Analysis of Behavior, 7, 383-385.

- Weiner, H. (1969). Controlling human fixed-interval performance. Journal of the Experimental Analysis of Behavior, 12, 349-373.

- Weiner, H. (1970). Human behavioral persistence. The Psychological Record, 20, 445-456.

- Weiner, H. (1972). Human fixed-ratio responding as a function of the type of reinforcer (money vs. points) and the presence or absence of a noncontingent monetary wage. The Psychological Record, 21, 497-500.

Datas de Publicação

-

Publicação nesta coleção

21 Jul 2011 -

Data do Fascículo

Jun 2011

Histórico

-

Revisado

18 Jan 2010 -

Recebido

24 Abr 2009 -

Aceito

25 Fev 2010