Resumos

Esta pesquisa analisou a eficiência educacional das Unidades Federativas (UF) do Brasil, relacionando o desempenho das instituições de Educação Básica com a qualidade alcançada pelas instituições do ensino superior. Além disso, investigou-se em qual nível da Educação Básica devem alocar-se esforços para melhoria da eficiência educacional de cada UF. A eficiência educacional foi medida considerando a relação entre o índice de qualidade do Ensino Superior (produto) e o desempenho da Educação Básica (insumos). O desempenho da educação básica levou em consideração o Índice de Desenvolvimento da Educação Básica (Ideb), já a qualidade do Ensino Superior foi determinada pelo Índice Geral de Cursos (IGC). Através de uma técnica denominada Data Envelopment Analysis, foram identificadas as UFs mais eficientes e as metas de melhoria para as menos eficientes. Os resultados indicaram ainda que, em geral, os anos iniciais do Ensino Fundamental merecem maior atenção por parte dos gestores e governantes.

Educação Básica; Ensino Superior; Análise envoltória de dados; Eficiência educacional

Este estudio analizó la eficiencia educacional de las Unidades de la Federación (UF) en Brasil, relacionando el desempeño de las instituciones de la educación básica con la calidad de la educación superior. Además, se investigó en qué nivel de la educación básica se deben destinar los esfuerzos para mejorar la eficiencia educacional de cada estado. La eficiencia educacional se midió teniendo en cuenta la relación entre el índice de calidad de la enseñanza superior (producto) y el rendimiento de la educación básica (insumos). El desempeño de la educación básica tuvo en cuenta el Índice de Desarrollo de la Educación Básica (IDEB), ya que la calidad de la educación superior fue determinada por el Índice General de Cursos (IGC). La técnica conocida como Análisis Exploratorio de Datos (DEA) se utilizó para identificar la UF más eficiente y las metas de mejora para los menos eficientes. Los resultados también señalan que, en general, los primeros años de educación primaria merecen mayor atención por parte de los gestores y gobernantes.

Educación básica; Educación superior; Análisis exploratorio de datos; Eficiencia de la educación

This research analyzed the educational efficiency of the educational Federal Units (FU) in Brazil, linking the performance of institutions of Basic Education institutions with the quality achieved by Higher education institutions. Furthermore, this research also investigated at which level of Basic Education more efforts should be allocated more efforts to improve the educational efficiency of each FU. The educational efficiency was measured considering the relationship between the index of quality in Higher Education (product) and the performance of basic education (inputs). The performance of basic education considered the Index of Basic Education Development (Ideb) and the performance of Higher Education was determined by the General Index of Courses (IGC). A technique called Data Envelopment Analysis was used to identify the most efficient FUs and to set the goals of the least efficient. The results also indicated that, in general, the early years of Basic Education deserve greater attention by managers and political leaders.

Basic education; Higher education; Data envelopment analysis; Efficiency of education

O impacto do desempenho das instituições de educação básica na qualidade do ensino superior

The impact of the performance of basic education institutions in the quality of higher education

El impacto del desempeño de las instituciones de educación básica en la calidad de la educación superior

Maria Cristina Nogueira GramaniI; André Luís de Castro Moura DuarteII

IDoutora em Engenharia, Universidade Estadual de Campinas (UNICAMP), Campinas, SP; Professora Assistente do Instituto de Ensino e Pesquisa (Insper). E-mail: MariaCNG@insper.edu.br

IIDoutor em Administração, Escola de Administração de Empresas de São Paulo, Fundação Getúlio Vargas (EAESP-FGV/SP); Professor Adjunto do Insper. E-mail: AndreLCMD@insper.edu.br

RESUMO

Esta pesquisa analisou a eficiência educacional das Unidades Federativas (UF) do Brasil, relacionando o desempenho das instituições de Educação Básica com a qualidade alcançada pelas instituições do ensino superior. Além disso, investigou-se em qual nível da Educação Básica devem alocar-se esforços para melhoria da eficiência educacional de cada UF. A eficiência educacional foi medida considerando a relação entre o índice de qualidade do Ensino Superior (produto) e o desempenho da Educação Básica (insumos). O desempenho da educação básica levou em consideração o Índice de Desenvolvimento da Educação Básica (Ideb), já a qualidade do Ensino Superior foi determinada pelo Índice Geral de Cursos (IGC). Através de uma técnica denominada Data Envelopment Analysis, foram identificadas as UFs mais eficientes e as metas de melhoria para as menos eficientes. Os resultados indicaram ainda que, em geral, os anos iniciais do Ensino Fundamental merecem maior atenção por parte dos gestores e governantes.

Palavras-chave: Educação Básica. Ensino Superior. Análise envoltória de dados. Eficiência educacional.

ABSTRACT

This research analyzed the educational efficiency of the educational Federal Units (FU) in Brazil, linking the performance of institutions of Basic Education institutions with the quality achieved by Higher education institutions. Furthermore, this research also investigated at which level of Basic Education more efforts should be allocated more efforts to improve the educational efficiency of each FU. The educational efficiency was measured considering the relationship between the index of quality in Higher Education (product) and the performance of basic education (inputs). The performance of basic education considered the Index of Basic Education Development (Ideb) and the performance of Higher Education was determined by the General Index of Courses (IGC). A technique called Data Envelopment Analysis was used to identify the most efficient FUs and to set the goals of the least efficient. The results also indicated that, in general, the early years of Basic Education deserve greater attention by managers and political leaders.

Keywords: Basic education. Higher education. Data envelopment analysis. Efficiency of education.

RESUMEN

Este estudio analizó la eficiencia educacional de las Unidades de la Federación (UF) en Brasil, relacionando el desempeño de las instituciones de la educación básica con la calidad de la educación superior. Además, se investigó en qué nivel de la educación básica se deben destinar los esfuerzos para mejorar la eficiencia educacional de cada estado. La eficiencia educacional se midió teniendo en cuenta la relación entre el índice de calidad de la enseñanza superior (producto) y el rendimiento de la educación básica (insumos). El desempeño de la educación básica tuvo en cuenta el Índice de Desarrollo de la Educación Básica (IDEB), ya que la calidad de la educación superior fue determinada por el Índice General de Cursos (IGC). La técnica conocida como Análisis Exploratorio de Datos (DEA) se utilizó para identificar la UF más eficiente y las metas de mejora para los menos eficientes. Los resultados también señalan que, en general, los primeros años de educación primaria merecen mayor atención por parte de los gestores y gobernantes.

Palabras clave: Educación básica. Educación superior. Análisis exploratorio de datos. Eficiencia de la educación.

Introdução

Mesmo com o grande desenvolvimento recente da economia brasileira, um assunto que ainda não foi equacionado de forma satisfatória é a questão educacional. Apesar de importantes mudanças realizadas nos últimos anos, como a introdução de exames nacionais para avaliação da qualidade do ensino, o Brasil ainda é caracterizado como um país de baixo nível educacional, tanto em termos de quantidade como em termos de qualidade da educação. Segundo Veloso (2009), no que diz respeito aos indicadores quantitativos, ocorreram avanços desde a década de 1990. Em 1995, 93% das crianças entre 7 e 14 anos frequentavam a escola, já em 2007, este número pulou para 98%. Na faixa de 15 a 17 anos, em 1995, apenas 64% dos jovens frequentavam a escola, este número subiu para 80%, em 2007. Neste mesmo período, a taxa de conclusão do ensino médio cresceu de 17% para 44%.

O mesmo não ocorreu com os indicadores de qualidade do ensino, afirma Veloso (2009, p. 10). Dados do Sistema de Avaliação da Educação Básica (Saeb) mostram uma queda significativa da qualidade da educação entre 1995 e 2001, medida pela quantidade de alunos com desempenho abaixo do esperado em língua portuguesa; ao mesmo tempo, estes valores não apresentaram evolução significativa de 2001 a 2007.

Outro ponto interessante apontado por Veloso (2009, p. 11) mostra que o investimento em educação no país (4,4% do PIB) é similar ao investimento em países como Coréia do Sul (4,4%) e Espanha (4,2%), sendo até maior que o investimento realizado pelo Japão (3,5%). Apesar disto, uma diferença importante apontada no estudo revela que grande parte da alocação do dinheiro público no país vai para o Ensino Superior e não para a Educação Básica (que engloba a Educação Infantil, o Ensino Fundamental e o Ensino Médio, conforme Figura 1). Constata-se, desta forma, um baixo nível relativo do gasto por aluno na Educação Básica. Assim, em geral, a literatura referente à eficiência da Educação Básica se concentra na análise dos gastos públicos em educação (ZOGHBI et al., 2009; GOUVEIA, 2009).

Por outro lado, com relação à qualidade do Ensino Superior, em geral a literatura reúne artigos que tanto analisam o avanço das avaliações da qualidade do ensino (DIAS; HORIGUELA; MARCHELLI, 2006; POLIDORI; ARAÚJO; BARREYRO, 2006; FREITAS; RODRIGUES; COSTA, 2009) como também reúne artigos que comparam a eficiência entre instituições de Ensino Superior (ZAINKO, 2008; BARBOSA; WILHEM, 2009; ÇOKGEZEN, 2009; HU; ZHANG; LIANG, 2009; KAO; PAO, 2009).

Entretanto, o desempenho do aluno na Educação Básica influencia a qualidade deste aluno no Ensino Superior, segundo Leitão e outros (2010), um curso que recebe alunos com formação prévia deficiente pode realizar um excelente trabalho, mas, ainda assim, não terá seus ex-alunos entre os melhores profissionais.

Neste sentido, não se encontra na literatura uma análise da eficiência educacional dos estados brasileiros englobando tanto a Educação Básica como o Ensino Superior.

Com o intuito de contribuir para essa questão, este artigo tem como objetivo relacionar o desempenho da Educação Básica com a qualidade do Ensino Superior, buscando identificar os níveis do Ensino Fundamental e Médio onde mais esforços devem ser alocados para que a melhor eficiência educacional de cada Unidade Federativa (UF) seja obtida.

Como eficiência educacional entende-se a relação entre o Índice Geral de Cursos (IGC) das instituições do Ensino Superior e as notas do Índice de Desenvolvimento da Educação Básica (Ideb) para os anos iniciais e finais do Ensino Fundamental e Ensino Médio. Sendo assim, neste trabalho propomos responder às seguintes questões:

1) Quais UFs têm a maior eficiência educacional, ou seja, quais possuem a melhor relação entre o IGC e as notas do Ideb?

2) Quais UFs são menos eficientes nesta relação?

3) Quais os níveis do Ensino Fundamental e Médio que mais influenciam a eficiência das instituições de ensino?

4) Quais metas precisam ser atingidas para a máxima eficiência, ou seja, em quanto se deve melhorar cada um dos níveis dos Ensinos Fundamental e Médio para que a UF seja considerada eficiente?

Na próxima seção, apresentamos uma descrição dos índices de desempenho do ensino existentes no país, tanto da Educação Básica como do ensino superior. O objetivo é apresentar como as UFs medem o desempenho do ensino. A seguir apresentamos os aspectos metodológicos do trabalho, dando ênfase à técnica análise envoltória de dados, Data Envelopment Analysis (DEA), à escolha das unidades a serem comparadas e às suas variáveis de insumos e produtos. Finalmente, uma análise preliminar é seguida da apresentação dos resultados e das considerações finais do trabalho.

Índices de desempenho do ensino no Brasil

Em 2007 o Ministério da Educação (MEC) lançou o Plano de Desenvolvimento da Educação (PDE), com foco prioritário na Educação Básica e cujo objetivo consiste em melhorar a qualidade da educação no País. O PDE estabeleceu um Plano de Metas: compromisso todos pela educação, onde todos os Municípios e Unidades Federadas podem participar e, a fim de estabelecer um plano de metas de qualidade a serem alcançadas: criou-se o Ideb.

O Ideb reúne num só indicador dois conceitos referentes à qualidade da educação:

O fluxo escolar, que se entende por taxa de aprovação, ou rendimento escolar, coletado anualmente pelo Inep a partir do Censo Escolar e,

As médias de desempenho escolar medidas através de exames como a Prova Brasil e o Saeb.

A Prova Brasil foi criada em 2005 e é realizada a cada dois anos, com última prova realizada em 2009; o Saeb, por sua vez, foi aplicado pela primeira vez, em 1990, e também é realizado a cada dois anos : sua última aplicação ocorreu em 2009. O Quadro 1, a seguir, resume as principais diferenças e similaridades entre as duas provas.

Com base nestes dados, o Ideb é calculado por meio da seguinte fórmula (INEP, 2010a):

em que:

i = ano do exame (Saeb e Prova Brasil) e do Censo Escolar;

Nji = média da proficiência em Língua portuguesa e Matemática, padronizada para um indicador entre 0 e 10, dos alunos da unidade j, obtida em determinada edição do exame realizado ao final da etapa de ensino;

Pji = indicador de rendimento baseado na taxa de aprovação da etapa de ensino dos alunos da unidade j.

Portanto, com este índice (Ideb), o MEC pretende verificar a taxa de alunos aprovados e que progridem dentro do sistema educacional e, além disto, verificar se estes alunos conseguem ter um aprendizado satisfatório.

Ainda mais, no PDE, o MEC fixou as seguintes metas para o Ideb em 2022:

Anos iniciais do Ensino Fundamental: meta de 6,0 (média Brasil em 2007: 4,0);

Anos finais do Ensino Fundamental: meta de 5,5 (média Brasil em 2007: 3,6),

Ensino Médio: meta de 5,2 (média Brasil em 2007: 3,3).

O ano de 2022 é simbólico porque é o bicentenário da independência do Brasil. Daqui até lá, porém, cada escola pode (e deve) traçar as suas próprias metas intermediárias, dependendo das notas que lhe foram atribuídas no Ideb. Entretanto, o Ministério da Educação disponibiliza estratégias para melhoria do Ideb, tais como Projeto EducaCenso, Prova Brasil, Pró-letramento, PDE Escola, Mais Educação, Aprova Brasil, etc. Maiores detalhes sobre cada estratégia podem ser encontrados no site do Ministério da Educação.

Dentro de uma política similar de avaliação, o Instituto Nacional de Estudos e Pesquisas Educacionais Anísio (Inep) também implementou um sistema de avaliação para o ensino superior. O principal indicador deste sistema é o Índice Geral de Cursos das instituições (IGC). O IGC é composto por uma média ponderada dos conceitos dos cursos de graduação e pós-graduação (mestrado e doutorado) da instituição. Para ponderar os conceitos, utiliza-se a distribuição dos alunos da instituição de Ensino Superior entre os diferentes níveis de ensino (graduação, mestrado e doutorado).

O conceito de qualidade para a graduação é calculado com base no Conceito Preliminar de Cursos (CPC). O CPC é resultado dos conceitos do Exame Nacional de Desempenho de Estudantes (Enade), Indicador de Diferença dentre os Desempenhos Observado e Esperado (IDD) e das chamadas variáveis de insumo, que consideram a qualidade do corpo docente, infraestrutura e programa pedagógico do curso. Como cada área de conhecimento é avaliada de três em três anos no ENADE, o IGC leva em conta sempre um triênio. Por exemplo, o IGC de 2007 considerou os CPCs dos cursos de graduação que fizeram o ENADE em 2007, 2006 e 2005.

Já para os cursos de pós-graduação valem os conceitos fixados pela Coordenação de Aperfeiçoamento de Pessoal de Nível Superior (Capes). Vale dizer que nas instituições sem cursos ou programas de pós-graduação avaliados pela Capes, o IGC é simplesmente a média ponderada dos cursos de graduação.

Assim, utilizaremos neste artigo como insumos as três notas Ideb (para os anos iniciais do Ensino Fundamental, anos finais do Ensino Fundamental e Ensino Médio) para representar o desempenho das instituições de Educação Básica e, como produto, o IGC para denotar a qualidade das instituições do Ensino Superior.

Metodologia

Como eficiência entende-se a relação entre produtos e insumos. Caso estivéssemos tratando com apenas um insumo e um produto, a eficiência seria facilmente calculada fazendo Produto/Insumo. Entretanto neste artigo, estamos tratando com múltiplos insumos, o que dificulta o cálculo da eficiência. Para isso, usaremos a técnica não paramétrica de programação linear Data Envelopment Analysis (DEA), que relaciona múltiplos insumos e produtos de forma a calcular uma eficiência relativa entre unidades produtivas, chamadas Decision Making Units (DMUs). As DMUs devem ser semelhantes diferindo apenas nas quantidades de insumos e produtos a serem utilizados/produzidos, conforme mostra a Figura 2.

A técnica DEA vem sendo aplicada na avaliação de políticas públicas por diversos autores em diferentes setores, tais como, hospitais públicos, gestão do programa bolsa-família, etc (LINS et al., 2007; FARIA; JANUZZI; SILVA, 2008; PEDROSO; CALMON; BANDEIRA, 2009).

No setor da educação a DEA é mais aplicada ao Ensino Superior, comparando ou a eficiência entre instituições de Ensino Superior públicas; ou comparando a eficiência entre os diferentes departamentos de universidades ou também fazendo comparações de eficiência entre instituições públicas e privadas (AHN; CHARNES; COOPER, 1988; JOHNES; JOHNES, 1993; FAÇANHA; REZENDE; MARINHO, 1997; MARINHO; RESENDE; FAÇANHA, 1997; KÖKSAL; NALÇACI, 2006; BARBOSA; WILHEM, 2009; ÇOKGEZEN, 2009; HU; ZHANG; LIANG, 2009; KAO; PAO, 2009).

Pouco se encontra a respeito de eficiência de instituições de Educação Básica. Barbosa e Wilhem (2009) analisaram o desempenho das escolas de Ensino Fundamental e Médio do Núcleo Regional de Educação de Paranavaí Paraná, usando a técnica DEA. Os autores verificaram falhas dos gestores, ao direcionarem recursos e esforços para que as escolas ineficientes funcionem eficientemente. Também Delgado e Machado (2008) usaram a DEA para calcular a eficiência de escolas públicas do Ensino Básico no Estado de Minas Gerais.

Entretanto, uma análise de eficiência da Educação Básica a nível nacional, ou, mais ainda, uma análise da influência do desempenho da educação básica na qualidade do ensino superior, não se encontra na literatura. E é neste ponto que este artigo busca contribuir.

Análise Envoltória de Dados (Data Envelopment Analysis - DEA)

Existem dois modelos DEA clássicos: CRS e VRS. O modelo Constant Returns to Scale (CRS) trabalha com retornos constantes de escala (CHARNES; COOPER; RHODES, 1978), ou seja, um aumento nos insumos gera um aumento proporcional nos produtos. O modelo Variable Returns to Scale (VRS), por outro lado, considera situações de eficiência de produção com variação de escala e não assume proporcionalidade entre insumos e produtos (BANKER; CHARNES; COOPER, 1984). Coelli (1994) sugere o VRS para proplemas com interferências a respeito de competição imperfeita, restrições financeiras, etc. Como este não é nosso caso, usaremos o modelo CRS.

A Figura 3 mostra as fronteiras dos modelos VRS e CRS para um problema bidimensional (considerando 1 insumo e 1 produto). As DMU´s A, B e C são VRS eficientes e a DMU B é CRS eficiente (diagonal que representa que um aumento no insumo gera o mesmo aumento no produto). As DMU´s D e E são ineficientes nos dois modelos. A eficiência CRS e VRS da DMU E é dada, respectivamente, por  e

e  . Note que como o modelo VRS é mais flexível, qualquer DMU CRS-eficiente também é VRS-eficiente (MELLO et al. , 2005).

. Note que como o modelo VRS é mais flexível, qualquer DMU CRS-eficiente também é VRS-eficiente (MELLO et al. , 2005).

Além da escolha dos modelos entre CRS e VRS, também deve-se escolher-se sua orientação: orientação a insumos (quando se deseja minimizar os insumos, mantendo os valores dos produtos constantes) e orientação a produtos (quando se deseja maximizar os produtos mantendo o nível de insumos constante). Neste trabalho, como buscamos encontrar o nível da Educação Básica que mais afeta a qualidade do Ensino Superior, escolhemos a orientação a insumos.

Com o modelo definido, a técnica DEA deverá fornecer informações sobre:

As DMU's eficientes;

O benchmark para as DMUs ineficientes;

As metas para cada DMU não eficiente atingir a eficiência, entre outras informações.

Todas estas informações têm como objetivo auxiliar a tomada de decisão de gestores, principalmente em relação à melhor alocação de recursos. É importante destacar que a técnica DEA calcula a eficiência relativa entre as DMUs, ou seja, não significa que a DMU mais eficiente pela técnica DEA não possa ainda melhorar, apenas que esta DMU é a mais eficiente em relação às demais consideradas.

Seleção das DMU's, insumos e produtos

O objetivo deste trabalho consiste em verificar como o desempenho da Educação Básica afeta a qualidade do Ensino Superior, mais especificamente, qual nível da educação básica mais afeta a qualidade do Ensino Superior. Com o intuito de fazer uma comparação a nível nacional, serão utilizadas como DMU´s no modelo DEA as unidades federativas do Brasil, ou seja, a princípio serão utilizados os 26 estados brasileiros e o Distrito Federal, ou seja, 27 UFs.

Na literatura que utiliza a DEA no setor de educação, é comum encontrarmos como variáveis de insumo, o número de docentes com/sem titulação, o número de funcionários administrativos, dados da infraestrutura, dados relacionados à pesquisa tais como número de publicações, entre outros. Porém, como neste artigo estamos interessados no desempenho das instituições de Educação Básica, utilizaremos como insumo as médias das notas Ideb de cada UF obtidas para os anos iniciais do ensino fundamental, anos finais do Ensino Fundamental e para o Ensino Médio. Estas notas retratam o desempenho das instituições básicas de cada UF para o ano de 2007.

Com relação à variável produto, a literatura, em geral, utiliza o número de matriculados ou o número de formandos, mas novamente, neste artigo, estamos interessados na qualidade do Ensino Superior, logo consideramos como produto a média das notas do IGC obtida por cada UF, considerando também o ano de 2007.

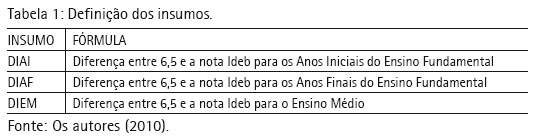

É importante destacar que a técnica DEA requer que os insumos sejam variáveis a serem minimizadas e os produtos variáveis a serem maximizadas. Obviamente, não desejamos minimizar as notas Ideb, portanto, para adequar estas variáveis à metodologia DEA, será utilizada a subtração da nota 6,5 (um pouco acima das metas arbitradas pelo MEC) pela nota do Ideb. Assim, é suposto desejar que a diferença (6,5 nota Ideb) seja a menor possível, ou seja, desta forma, utilizaremos os insumos DIAI, DIAF e DIEM (como descritos na Tabela 1) a serem minimizados.

Pode-se notar que tanto os insumos como o produto são variáveis relacionadas às instituições de ensino e não especificamente ao desempenho do estudante (a nota Ideb é calculada por meio das notas dos alunos e do fluxo escolar, resultando em uma nota da instituição. O IGC é calculado como uma média ponderada dos conceitos dos cursos de graduação e pós-graduação, resultando também em uma nota institucional).

Por fim, a Figura 4 resume as variáveis a serem utilizadas no cálculo da eficiência educacional das 27 DMUs.

É importante destacar que se utilizou como premissa o fato de ter sido considerado que os alunos que cursam a Educação Básica em um Estado continuam neste Estado para a Educação Superior. Segundo o presidente do Inep, no Brasil, apenas 0,04% dos estudantes mudam de Estado para estudar, contra 20% nos Estados Unidos (MANDELLI, 2009).

Com o modelo definido, na próxima seção será verificada a consistência das DMU´s, e variáveis escolhidas por meio de algumas armadilhas citadas por Dyson e outros (2001) e, em seguida mostraremos os resultados preliminares da técnica DEA, seguida de uma análise de sensibilidade.

Análise preliminar da DEA

Nesta seção, discutimos alguns cuidados que devem ser tomados antes de se aplicar a técnica DEA, os resultados preliminares obtidos e uma análise de sensibilidade a fim de identificar possíveis gaps na interpretação dos resultados.

Armadilhas DEA

Com o intuito de obter resultados consistentes, antes de aplicarmos a DEA, verificamos se as DMU´s e as variáveis escolhidas se encaixam em alguma das armadilhas discutidas por Dyson e outros (2001). A Tabela 2 mostra na primeira coluna as possíveis armadilhas, a segunda coluna descreve o procedimento a ser aplicado a fim de verificar a consistência do modelo DEA e por fim, na terceira coluna, mostramos os resultados da aplicação dos procedimentos para o problema proposto neste artigo.

Resultados preliminares DEA

Após verificar que as variáveis e DMUs escolhidas para o modelo DEA são consistentes, aplicamos a técnica DEA utilizando o software Frontier Analyst 4. A Tabela 4 mostra os dados de insumos e produto utilizados no modelo.

Nesta primeira análise (conforme Tabela 5), encontramos duas DMU´s 100% eficientes, PR e SC com os seguintes benchmarkings: a última coluna da Tabela 5 mostra que a DMU SC é referência de unidade eficiente para outras 24 UFs e ela mesma, e PR para apenas 1 outra UF e ela mesma. Assim, percebe-se que, neste cenário, existe uma forte predominância da DMU Santa Catarina sobre as demais UFs.

Ainda na Tabela 5, além do percentual de eficiência de cada DMU (segunda coluna), esta tabela mostra também as metas que cada DMU deve atingir por cada insumo e produto (colunas 3, 4, 5 e 6) e seus respectivos potenciais de melhorias para chegar à meta (colunas 7, 8 e 9). Por exemplo, para que a DMU AL seja considerada 100% eficiente, esta tem como meta melhorar a nota do Ideb para os anos iniciais do Ensino Fundamental - de 3,3 para 5,3; anos finais do Ensino Fundamental de 2,7 para 4,8; Ensino Médio de 2,9 para 4,6, ou seja, o potencial de melhorias para cada insumo é de 62%, 56% e 47,3%, para os anos iniciais, anos finais e Ensino Médio, respectivamente. Além disso, podemos ver, na tabela 5, que esta é a UF com menor eficiência, ou seja, a que possui o maior potencial de melhorias.

Percebemos, de maneira geral, que os resultados mostram que as notas do Ideb para os anos iniciais do Ensino Fundamental possuem um maior potencial de melhorias, de 37,5%, ou seja, esses são os anos que mais requerem melhorias.

Entretanto, para intensificar a consistência dos resultados, reorganizamos os dados (de potencial de melhorias da Tabela 5) por regiões brasileiras, calculamos as médias dos potenciais de melhorias das UFs do norte, nordeste, centro, sudeste e sul, conforme mostra a Tabela 6.

Assim, ao invés de termos os dados para cada UF, temos os dados por região, e por essa nova tabela 6, novamente os anos iniciais do Ensino Fundamental são os que mais requerem melhorias. Apenas no Sudeste, o maior potencial de melhorias refere-se ao Ensino Médio (16,2%), mas está muito próximo do potencial de melhorias para os anos iniciais (15,8%).

Análise de sensibilidade dos resultados DEA

Ramanathan (2003) sugere uma análise de sensibilidade para os seguintes dois casos:

1) Se uma DMU é inicialmente identificada como eficiente pela metodologia DEA, uma análise de sensibilidade deve ser realizada verificando o número de DMU´s ineficientes as quais seguem a referência desta DMU eficiente. Se este número for alto, então a DMU é genuinamente eficiente; a eficiência de uma DMU com poucas referências deve sempre ser vista com precaução.

2) Uma DMU que muda seu status de eficiência pela omissão/inclusão de um insumo ou produto, apenas, deve ser analisada com cuidado.

Para o primeiro caso, temos duas DMU´s eficientes, uma (SC) com um número alto de referências (25) e outra (PR) com um número muito baixo (2). Para analisar estes dois casos com mais detalhes, elaboramos o cenário 2, retirando a DMU SC, ou seja, descartando o outlier, e um cenário 3, descartando a DMU PR que é eficiente, mas é referência para apenas outra DMU.

Para o segundo caso, fizemos os testes retirando os insumos um a um, e obtivemos, em apenas um caso, uma DMU que deixou de ser 100% eficiente, entretanto este caso não foi tratado com relevância, pois esta DMU ficou entre 90 e 99% de eficiência. A retirada do produto obviamente não foi feita, pois só existe um.

Resultados da DEA: comparação entre três cenários

Seguindo a análise de sensibilidade feita anteriormente, a fim de obter uma melhor consistência dos resultados obtidos pela DEA, foram elaborados três cenários para análise: o Cenário 1 com todas as 27 DMUs, o Cenário 2 com 26 DMUs (retirando apenas DMU SC), e o Cenário 3 também com 26 DMUs (retirando apenas a DMU PR). Todos os três cenários consideram como insumos o DIAI, DIAF e DIEM, e como produto o IGC.

E, utilizando novamente o software Frontier Analyst 4, encontramos os seguintes resultados:

A Tabela 7 mostra que, no cenário 2, duas DMU´s servem de referência para as demais, mas não mais com números extremos como no Cenário 1 (não tem mais nenhuma DMU referência para apenas outra DMU). No cenário 3, apenas uma DMU é referência para todas as demais.

A importância das variáveis de insumos e produto é mostrada pela correlação destas com a eficiência (conforme Tabela 8). A correlação entre as variáveis de insumo (DIAI, DIAF e DIEM) e a eficiência varia entre -0,78 e -0,89, o que indica que quanto menores os valores de insumo, maior a eficiência da UF. A negatividade é esperada por se desejar os menores valores para os insumos DIAI, DIAF e DIEM (por ser a diferença entre 6,5 e a nota IDEB). A correlação entre o produto IGC e a eficiência varia entre 0,68 e 0,69 nos três cenários, o que indica que, quanto maior o IGC, maior a eficiência. Ou seja, todas as variáveis de insumo e produto possuem alta correlação com a eficiência.

A figura 5 mostra a distribuição das eficiências para os três cenários, ou seja, a quantidade de UFs nos intervalos de eficiência. Por exemplo, os cenários 1 e 2 possuem uma UF 100% eficiente a mais que o cenário 3, e assim por diante. Entretanto, não se percebe diferenças significativas entre os três cenários, o que sugere eficiências similares independente do cenário escolhido.

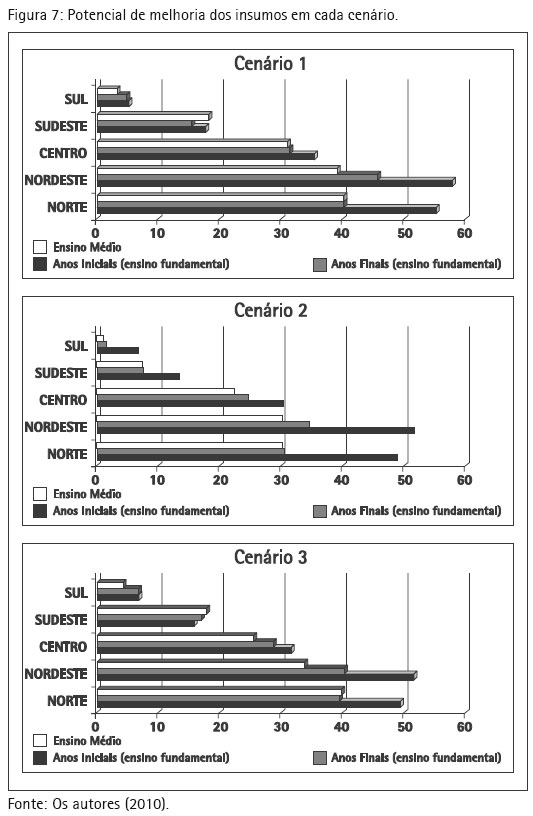

Novamente, assim como foi feito inicialmente para o primeiro cenário (na seção anterior), fizemos uma análise por regiões do Brasil, comparando as médias dos resultados dos três cenários.

A figura 6 mostra as médias de eficiência para cada região em cada cenário. As regiões norte, nordeste e centro apresentam os menores índices de eficiência e a região sul apresenta a melhor eficiência em todos os cenários.

A eficiência por região se relaciona com o potencial de melhorias de cada região, dado pela Figura 7. Quanto maior a eficiência da região, menor seu potencial de melhorias (não precisa melhorar tanto). Nesta figura, também se pode notar que nas regiões norte, nordeste e centro o insumo DIAI é a variável com maior potencial de melhorias, ou seja, este seria o nível da Educação Básica indicado para alocar mais recursos. Exceto para a região sudeste nos cenários 1 e 3, observamos que o Ensino Médio possui um maior potencial de melhorias.

Por fim, os resultados mostram que os anos iniciais do Ensino Fundamental são as séries que mais influenciam a qualidade do Ensino Superior na maioria das UFs brasileiras. Novamente, vale lembrar que a DEA calcula a eficiência relativa, portanto não significa que a região Sul não possa melhorar, apenas que em relação às demais regiões brasileiras, esta se encontra em melhor posição.

Considerações finais

Tendo em vista a necessidade de otimizar a alocação de recursos, este trabalho contempla a relação entre o desempenho da Educação Básica e a qualidade do Ensino Superior, mais especificamente, busca indicar qual nível da Educação Básica (anos iniciais do Ensino Fundamental, anos finais do Ensino Fundamental ou Ensino Médio) mais afeta a qualidade do Ensino Superior.

Com o intuito de analisar o desempenho institucional e não por estudantes, foram comparadas as 27 unidades federativas do Brasil, utilizando variáveis de insumo relacionadas às instituições de ensino, tais como os índices do Ideb para anos iniciais do Ensino Fundamental, anos finais do Ensino Fundamental e Ensino Médio e, como variável de produto, a notas da instituição de Ensino Superior, o IGC.

Como estamos tratando com múltiplos insumos, a técnica DEA foi utilizada a fim de calcular a eficiência educacional de cada UF e análises foram desenvolvidas. Os resultados obtidos mostram a região Sul como a mais eficiente e o insumo referente aos anos iniciais do Ensino Fundamental com o maior potencial de melhorias, ou seja, para que as UFs ineficientes se tornem eficientes, em geral, os resultados sugerem primeiro melhorar os anos iniciais do Ensino Fundamental.

Podemos considerar algumas causas para a necessidade maior em melhorias nas quatro primeiras séries do Ensino Fundamental. Segundo Ferreira (2010), em 2007, 65% dos professores da educação fundamental (quatro séries iniciais) possuía formação profissional em nível superior, embora a LDB (BRASIL, 1996) indicasse que todos deveriam ter nível superior. Ainda segundo a mesma autora, os dados do Censo dos Profissionais do Magistério, de 2003, sugeriram que os professores atuantes na Educação Infantil e no Ensino Fundamental de primeira a quarta série recebiam os salários mais baixos, em média, 20% a menos que os professores do ensino fundamental de 5ª a 8ª séries, e 36% a menos que aqueles que atuavam no Ensino Médio. Enfim, como pesquisa futura, pretende-se analisar qual o(s) fator(es) relacionado(s) à qualidade da Educação Básica nos quatro primeiros anos do Ensino Fundamental mais afeta(m) seu desempenho.

Recebido em: 29/06/2010

Aceito para publicação em: 15/05/2011

- AHN, T.; CHARNES, A.; COOPER, W. Some statistical and DEA evaluations of relative efficiencies of public and private institutions of higher learning. Socio-Economic Planning Sciences, Amsterdam, v. 22, n. 6, p. 259-269, 1988.

- BANKER, R. D.; CHARNES, A.; COOPER, W.W. Some models for estimating technical and scale efficiencies in Data Envelopment Analysis. Management Science, Philadelphia, PA, v. 30, p. 1078-1092, 1984.

- BARBOSA, S. G.; WILHEM, V. E. Avaliação do desempenho das escolas públicas por meio de Data Envelopment Analysis. Acta Scientiarum: technology, Maringá, PR, v. 31, n. 1, p. 71-79, 2009.

- CHARNES, A.; COOPER, W.W.; RHODES, E. Measuring efficiency of decision making units. European Journal of Operational Research, vol.1, p. 429-44, 1978.

- COELLI, T. J. A guide to DEAP version 21: a Data Envelopment Analysis (Computer) Program. Armidale: Department of Econometrics, University of New England, 1994. Mimeografado.

- ÇOKGEZEN, M. Technical efficiencies of faculties of economics in Turkey. Education Economics, London, v. 17, n. 1, p. 81-94, 2009.

- DELGADO, V. M. S.; MACHADO, A. F. Eficiência das escolas públicas estaduais de Minas Gerais. Pesquisa e Planejamento Econômico, Rio de Janeiro, v. 37, n. 3, p. 427-464, 2008.

- DIAS, C. L.; HORIGUELA, M. de L. M. ; MARCHELLI, P. S. Políticas para avaliação da qualidade do Ensino Superior no Brasil: um balanço crítico. Educação e Pesquisa, São Paulo, v. 32, n. 3, p. 435-464, 2006.

- DYSON, R. G. et al. Pitfalls and protocols in DEA. European Journal of Operational Research, Amsterdam, v. 132, p. 245-259, 2001.

- FAÇANHA, L.; RESENDE, M.; MARINHO, A. Brazilian federal universities: relative efficiency evaluation and data envelopment analysis. Revista Brasileira de Economia, Rio de Janeiro, v. 51, n. 4, p. 489-508, 1997.

- FARIA, F. P.; JANUZZI, P. M.; SILVA, S. J. Eficiência dos gastos municipais em saúde e educação: uma investigação através da análise envoltória no estado do Rio de Janeiro. Revista de Administração Pública, Rio de Janeiro, v. 42, n.1,p. 155-177, 2008.

- FERREIRA, L. L. Relações entre o trabalho e a saúde de professores na educação básica no Brasil: relatório final do Projeto Condições de Trabalho e suas Repercussões na Saúde dos Professores de Educação Básica no Brasil. São Paulo: Fundacentro, 2010. Acesso em: <http://www.fundacentro.gov.br/dominios/CTN/anexos/relatoriofinal.pdf>. Acesso em: 23 jun. 2010.

- FREITAS, A. L. P.; RODRIGUES, S. G.; COSTA, H. G. Emprego de uma abordagem multicritério para classificação do desempenho de instituições de ensino superior. Ensaio: avaliação e políticas públicas em educação, Rio de Janeiro, v.17, n. 65, p. 655-674, 2009.

- GOUVEIA, A. B. Avaliação da política educacional municipal: em busca de indicadores de efetividade nos âmbitos do acesso, gestão e financiamento. Ensaio: avaliação e políticas públicas em educação, Rio de Janeiro, v. 17, n. 64, p. 449-476, 2009.

- HU, Y.; ZHANG, Z.; LIANG, W. Efficiency of primary schools in Beijing, China: an evaluation by data envelopment analysis. International Journal of Educational Management, Cambridge, MA, v. 23, n. 1, p. 34-50, 2009.

- INEP. IDEB Brasília, DF, 2010a. Disponível em: <http://portalideb.inep.gov.br>. Acesso em: 11 ago. 2011.

- ______. Prova Brasil e Saeb. Brasília, DF, 2010b. Disponível em: <http://portal.inep.gov.br/web/prova-brasil-e-saeb/prova-brasil-e-saeb>. Acesso em: 11 ago. 2011.

- JOHNES, G.; JOHNES, J. Measuring the research performance of UK Economics Departments: an application of Data Envelopment Analysis. Oxford Economic Papers, New Series, v. 45, n. 2, p. 332-347, 1993.

- KÖKSAL, G.; NALÇACI, B. The relative efficiency of departments at a Turkish engineering college: a data envelopment analysis. Higher Education, New York, v. 51, p. 173-189, 2006.

- KAO, C.; PAO, H. An evaluation of research performance in management of 168 Taiwan universities. Scientometrics, New York, v. 78, n. 2, p. 261-277, 2009.

- LEITÃO, H. dos A. et al. Análise acerca do boicote dos estudantes aos exames de avaliação do ensino superior. Estudos em Avaliação Educacional, São Paulo, n. 45, p. 110-117, jan./abr. 2010.

- LINS, M. E. et al. O uso da Análise Envoltória de Dados (DEA) para avaliação de hospitais universitários brasileiros. Ciência Saúde Coletiva, Rio de Janeiro, v.12, n. 4, p. 985-998, 2007.

- MANDELLI, M. Estudantes poderão concorrer a mais vagas com Enem. Estadão.com.br, São Paulo, 28 set. 2009. Disponível em: <http://www.estadao.com.br/noticias/suplementos, estudantes-poderao-concorrer-a-mais-vagas-com-enem,442207,0.htm>. Acesso em: 11 ago. 2011.

- MARINHO, A.; RESENDE, M.; FAÇANHA, L. Brazilian federal universities: relative efficiency evaluation and data envelopment analysis. Revista Brasileira de Economia, Rio de Janeiro, v. 51, n. 4, p. 489-508, 1997.

- MELLO, J. C. C. B. S. et al. Eficiência DEA como medida de desempenho de unidades policiais. Produção Online, Florianópolis, SC, v. 5, n. 3, 2005.

- POLIDORI, M. M.; ARAÚJO, C. M.; BARREYRO, G. B. SINAES: perspectivas e desafios na avaliação da educação superior brasileira. Ensaio: avaliação e políticas públicas em educação, Rio de Janeiro, v.14, n. 53, 2006.

- RAMANATHAN, R. An introduction to data envelopment analysis: a tool for performance measurement. Thousand Oaks, CA: Sage, 2003.

- VELOSO, F. 15 anos de avanços na educação no Brasil: onde estamos? In: VELOSO, F. et al. (Org.). Educação básica no Brasil: construindo o país do futuro. Rio de Janeiro: Campus, 2009. p. 3-24.

- ZAINKO, M. A. S. Avaliação da educação superior no Brasil: processo de construção histórica. Avaliação, Campinas, SP, v.13, n.3, p. 827-831, 2008.

- ZOGHBI, A. C. P. et al. Mensurando o desempenho e a eficiência dos gastos estaduais em educação fundamental e média. Estudos Econômicos, São Paulo, v. 39, n. 4, p. 785-809, 2009.

Datas de Publicação

-

Publicação nesta coleção

25 Out 2011 -

Data do Fascículo

Set 2011

Histórico

-

Recebido

29 Jun 2010 -

Aceito

15 Maio 2011